基于事件的视觉传感,变革机器视觉技术

基于事件的视觉传感,变革机器视觉技术

电子说

描述

目前,我们正处于机器视觉和人工智能转型的初期,据Yole Development等市场研究机构的分析,预计到2030年,视觉技术将创造价值100亿美元的市场。该技术会渗透到包括自动驾驶、AR、可穿戴计算成像、机器人技术等各个领域。

机器视觉和人工智能领域总是离不开视觉技术的,基于事件的神经拟态视觉是一种新的成像技术范式,可以极大提高机器感知周围环境的能力,从而做出智能决策。这种更进一步的视觉技术如何在机器视觉和人工智能领域创造新的技术标准,如何将现有应用的性能提升到全新的水平?

基于事件的视觉技术与传统图像传感器的本质区别

基于事件的神经拟态视觉技术受生物原理启发,与传统的图像传感器工作方式有很大的不同。类似于人眼视网膜,基于事件的神经拟态视觉技术传感器不会在固定的时间生成图像,而是着重于关注场景的动态变化。这种动态变化信息对于机器视觉和人工智能是相当重要的。这种工作原理意味着基于该技术的传感器采集图像的方式是异步的、连续的,在模拟域中运作。每个感光器都是独立的,只对变化的事物作出反应,静态的背景信息不会被一遍又一遍被重复采集。

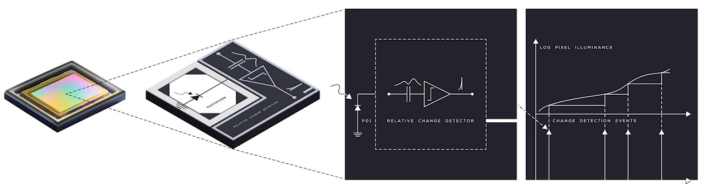

(像素的智能感知,Prophesee)

为了模拟这种生物学原理,需要设计智能像素,通过像素内嵌的智能设计来实现。上图所示的这套模拟处理系统,基于电平交叉采样威廉希尔官方网站

,每个像素都能够对场景中的亮度变化做出反应,从而压缩冗余,提高数据传输速率。

以上图中的传感器为例,其时间可以精确至微秒级,而且数据采集速度非常快,更重要的是每个像素都能独立异步工作。因此基于该技术的传感器的数据采集功能并不受场景中照明条件的影响。如此一来,这代表着其动态范围是比传统的图像传感器要高的,大概在120-130dB之间。

基于事件的异步自适应采样和基于帧的数据采样,差异也很明显。在固定时间获得的一系列图像不可避免地会导致信息的冗余,虽然其产生的信息在时间上是连续的,但由于数据采集本身的非连续性,帧与帧之间会缺失信息。基于事件的异步自适应采样只获取正在变化的信息,换个说法就是捕捉时空范围内连续的信息流(像素级别)。根据Prophesee的说法,这种传感器不会产生原始数据,而是仅提供处理任务所需的必要信息。

(采集对比,Prophesee)

图像之间隐藏信息

基于事件的传感器可以快速响应场景变化,揭示迄今为止基于帧的传感器难以记录的信息。基于帧的捕捉采集动态范围不可避免是有限的,而且对光照条件极度依赖,对于新兴的人工智能以及机器视觉并不友好。在对于运动物体的理解上,帧与帧之间是没有信息记录的,这对于理解整个运动来说是很困难的,甚至有时候是不可能的。而基于事件的传感带来的连续的信息流,让处理系统的跟踪变得更为容易,对动态信息的理解更深刻。这也意味着可以在本地更新跟踪,在时间准确度上提升一个大层次。

基于事件的传感器能记录亚毫秒时间级别的时间,等效于10000fps,能够捕捉到那些转瞬即逝的事件;因为不记录冗余数据,系统需要处理的数据减少了10至1000倍,对于关键动态信息的获取更准确;同时其高动态范围,能够抓取极端照明条件下隐藏起来的信息。

从机器学习的角度来看,这种连续的信息流抓取、跟踪,对于其数学模型的构建也是一个相当大的简化。

基于事件的传感器演进

目前,基于事件的视觉技术传感器已经发展到了第四代。采用背照式(BSI)3D堆栈工艺制造,硅面积相比第三代VGA传感器减少了10倍以上。因为将CIS层堆叠在了CMOS层之上,所以器件感光区域和逻辑威廉希尔官方网站

较之前代也有一定的优化。像素间距也降低至了4.86微米,加上超过80%的填充因子,传感器具备更高的光电性能。

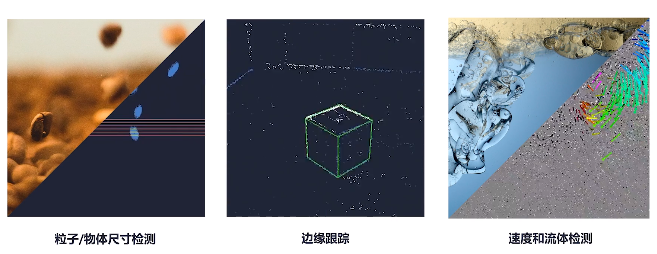

(应用场景,Prophesee)

基于该传感器的机器学习,可以不使用图像来训练神经网络识别物体,二是使用时间编码的信息。这给机器学习带来了不小的改变,一是无需等待帧图像大大降低了延迟,二是更容易泛化,抓取最主要的事件特征,减少数据集,最后则是减少了计算量。

小结

总的来看,基于事件的视觉传感技术不受帧速率限制,实现了更快的速度和更高动态范围,其生成的数据量比传统图像传感器少且功率更低(<10 mW),为机器视觉和人工智能提供了更具成本效益的视觉解决方案。

-

机器视觉与计算机视觉的关系简述2014-05-13 0

-

机器视觉技术2016-01-17 0

-

机器视觉表面缺陷检测技术2016-01-20 0

-

生活中“无处不在”的技术——机器视觉2019-06-21 0

-

机器视觉系统技术简介!(干货分享建议收藏)2019-12-17 0

-

视觉传感器的工作原理、应用和选型2020-08-05 0

-

机器人视觉与机器视觉有什么不一样?2020-08-28 0

-

基于ZYNQ的机器视觉应用2020-09-16 0

-

深圳机器视觉检测项目包括哪些?2020-11-11 0

-

机器视觉_ni机器视觉系统-技术专辑2012-08-03 1710

-

机器视觉是什么意思_机器视觉应用案例2020-03-26 7677

-

机器视觉及视觉传感器2020-10-19 7117

-

工业视觉AI机器人—机器视觉质检2023-05-31 1285

-

智能机器人视觉传感器的技术原理2022-10-27 1505

全部0条评论

快来发表一下你的评论吧 !