深度学习算法进行优化的处理器——NPU

人工智能

描述

NPU技术的发展

在上一篇文章中,我们了解了CPU*(中央处理单元)在移动设备中的作用。今天,继续向大家介绍针对深度学习算法进行优化的处理器——NPU。

NPU(Neural-network Processing Unit,嵌入式神经网络处理器)是针对深度学习*算法进行优化的处理器。它能像人类神经网络一样快速、高效地处理大量数据,因此它主要用于AI算法。

尽管可能看上去很复杂,但已普遍应用于各种智能设备。比如,借助NPU,智能手机的摄像头可根据取景框中的环境,自动识别物体和人物并进行对焦。在拍摄食物时自动开启食物滤镜,甚至可以去除画面中不需要的对象。

▲ 随着NPU的发展,新智能手机中的AI去除功能得以增强。 在过去没有NPU的时候,由GPU*(图形处理器)执行AI计算。但由于硬件结构差异,导致计算效率*较低。如今,AI计算主要由NPU负责,在移动设备上也能更高效地处理数据。NPU针对并行数据计算进行了优化,可让基于AI算法的应用程序在低功耗下更快运行。 Exynos的NPU开发始于2016年,第一款搭载NPU的SoC*(系统级芯片)是Exynos 9820,它被应用于2019年发布的Galaxy S10中。 “ 项目负责人Suknam Kwon说道:

6年前,第一个工作组成立时,我们只有大约20人。但如今,算上海外研究机构的成员,我们的团队已经是之前的10倍了。

” Kwon曾设计过SoC的硬件,从第2代产品开始就一直致力于NPU的开发。 “ 他还说道: 如今,NPU是一个备受关注的领域,但在过去,它是陌生而新鲜的,我们只有从海外的视频和大学讲座中才能学习到相关的知识。 ” 在过去,只有在像图像检测这样的领域才有NPU的应用。然而,在人工智能时代,具有强计算能力的高性能IP的市场需求不断增加,NPU可强化图像成像质量、提升语音服务能力等。 此外,随着IP性能的增强,尺寸和功耗随之增加,构建高效的逻辑架构成为了关键因素。

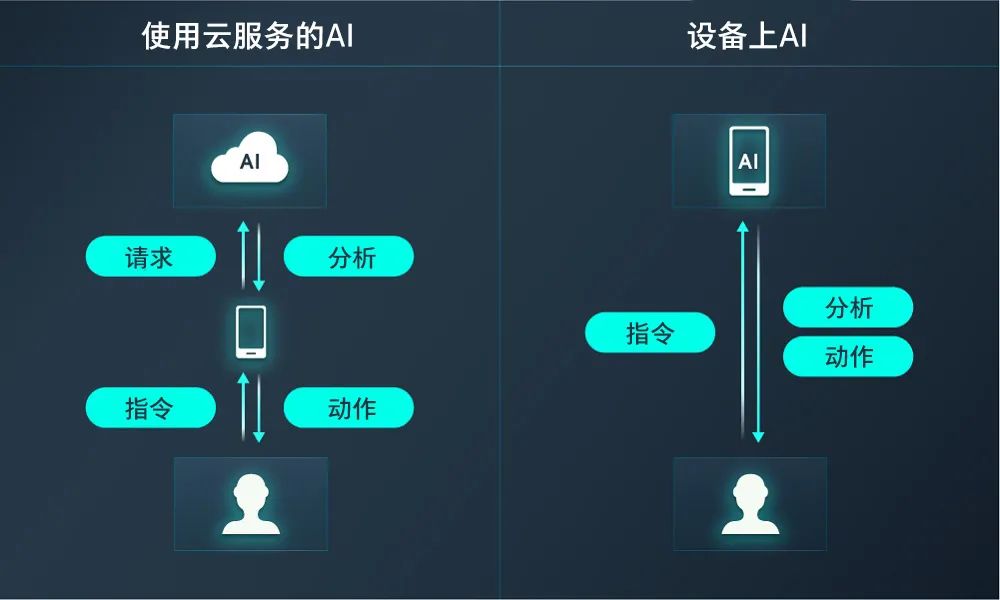

▲比较使用云服务的AI和设备上AI

随着 NPU 越来越强大,它在对象识别速度和改善图片质量方面有了进一步提升。与上一代相比,内置于新一代Exynos处理器的NPU,性能提升了两倍。 SoC设计团队已独立开发了六代NPU产品,拥有丰富的专业知识和实践经验。

“ Kwon表示:

凭借ML Perf、能效、尺寸等基准优势,Exynos的NPU是一个很有竞争力的IP解决方案。

”

在未来,与NPU相关的技术应用有望进一步发展。

“ Kwon说道: 设备上AI是一种无需经过服务器,即可直接在智能手机中执行AI计算的技术。这种技术在未来会得到更广泛的应用,可以降低个人信息泄露的风险。正因如此,移动NPU的性能需进一步提升。现如今,一个NPU可以用于很多计算,但根据我的预测,未来每个应用程序都会有特定的AI算法需求,开发针对特定领域的NPU也很重要。 ”

当被问及自动驾驶相关的问题时,Kwon谈到了未来NPU在行业中将要扮演的角色。

“ 他表示: 在不远的将来,高级辅助驾驶系统(ADAS)会成为现实,这就需要底层硬件具备操作海量数据以实时执行自动驾驶算法的能力。 想要实现这一目标,就需要更高性能的NPU,三星正在为自动驾驶设备开发具有强大功能的NPU,以满足市场需求。 ”

采访的最后,Kwon分享了开发过程中富有里程碑意义的瞬间。

“ 他说道: 每年,Exynos系列产品都会配备更高性能的NPU,这是十分有意义的。NPU将持续成为未来市场的关键IP。开发NPU促进了公司和我的共同成长,我深感自豪。这是一个能让‘想象’变为‘现实’的领域。 ”

*CPU:Central Processing Unit, 中央处理单元

*深度学习:使机器能像人类一样利用数据进行学习、推断和推理的技术。

*在移动SoC中,效率意味着消耗更少电能或拥有更快速度。

*GPU:graphics processing unit,图形处理器 *SoC:System on Chip,系统级芯片

编辑:黄飞

-

CPU,GPU,TPU,NPU都是什么2021-12-15 0

-

Arm Ethos-U NPU处理器入门指南2023-08-08 0

-

英伟达无人驾驶Xavier处理器帮助应用程序使用深度学习神经网络算法2017-12-19 4516

-

深度学习中多种优化算法2020-08-28 2591

-

什么是深度学习中优化算法2023-02-13 1591

-

深度学习算法简介 深度学习算法是什么 深度学习算法有哪些2023-08-17 8867

-

什么是深度学习算法?深度学习算法的应用2023-08-17 2142

-

npu是什么意思?npu芯片是什么意思?npu到底有什么用?2023-08-27 41673

-

npu是什么处理器?NPU卡是什么?2023-08-27 13865

-

如何利用ARMxy ARM嵌入式计算机的NPU进行深度学习模型的训练和优化?2024-08-20 326

-

NPU在深度学习中的应用2024-11-14 490

-

NPU技术如何提升AI性能2024-11-15 406

-

NPU的工作原理解析2024-11-15 576

-

NPU与机器学习算法的关系2024-11-15 425

-

NPU与传统处理器的区别是什么2024-11-15 358

全部0条评论

快来发表一下你的评论吧 !