动态视觉相机(DVS)和动态音频传感器(DAS)的工作原理

描述

作为整个计算的最前沿,传感效率的高低、传感信号和后端计算模式的匹配程度必然影响着整个智能系统的表现。类脑技术的完全体=事件驱动传感 + 异步类脑芯片计算,配合高效利用异步机制的算法。而脉冲神经网络的异步运算机制和仿生传感器天然契合。目前,SynSense时识科技使用类脑技术实现了mW级别的“感算一体”动态视觉智能SoC Speck,将这一新兴的传感+计算技术用于我们身边的电子器件及智能设备中。

动态视觉传感器

动态视觉相机 Dynamic Vision Sensor(DVS),有时候也称作事件相机(Event camera)或者硅视网膜(Silicon Retina)。提到DVS的起源就要追溯到它的发明者Misha Mahowald。Misha师从类脑工程领域的提出者Carver Mead (Carver mead 同时还是VLSI威廉希尔官方网站 设计的大牛级别人物,也被认为是摩尔定律的命名者)。在博士期间,她和Tobi Delbruck创举性地结合生物学计算机科学和电气工程领域,创建了第一个硅视网膜系统,这也是最早的动态视觉相机的原型。之后,她和Tobi Delbruck还有几位现在的类脑技术大牛们一起将技术带到了苏黎世,并和苏黎世联邦理工、苏黎世大学联合创办了INI神经信息研究所(Institute of Neuroinformatics),专注于研究神经科学、神经形态相关的技术。硅视网膜就是其中重要的一项技术。1996年Misha因为这一非凡的工程案例成为国际科技女性(WITI)名人堂成员,遗憾的是Misha在33岁结束了自己年轻的生命。

但是硅电子视网膜的技术并未停滞,而是经过十几年的发展变得更加成熟。从INI出来的公司iniVation已经将DVS变成成熟的产品,不仅整个传感器集成了仿生的事件像素阵列,还在外围同步集成了如RGB相机、IMU传感器,帮助其实现更强大的信息同步和收集能力。另一公司Prophesee提供高分辨率的动态视觉传感器,并和Sony合作将先进光学电子工艺和DVS结合,大大减小了芯片面积和光学性能。此外,在应用算法层面,也有越来越多的科研学者和工程师专家已经把事件相机信号应用在各行各业中。

什么是DVS?可简要概括为:只对运动的目标成像。

从工作原理上来讲, DVS最大的特点之一则是:异步感知。

我们拿传统的数字相机来对比:

对于传统相机来说,每个感光原件会根据一定的采样率对整个感光阵列进行同步的采样, 因此每次成像需要依赖于一个时钟信号当作reference。以这样的形式,我们得到了一个对光电流信号采样的真实值的阵列。假设说我们有100x100大小的一个像素阵列,RGB三个采样通道和1/30秒的采样率的话,我们每秒就会得到100x100x30x3的数组,其中100x100x3就是我们常说的一帧图片。

区别在于,对于同样100x100的像素阵列来说,DVS里的每个像素的工作是相互独立、互不干涉的。也就是说每个感光像素都只对自己所负责的一部分区域进行独立感光。同时,每个感光像素都不再直接采样实值,而是时时刻刻去比较光电流的相对变化值是否超过了一个阈值。相对应来说,光照强度的变化对应着光电流的大小变化,其实DVS上的每一个像素位置是在感受相对光照强度的变化是否明显。当在对应像素上感受到足够的光强变化时, 传感器就会发出一个“事件信号”,通常来说这个信号是一个数据包,包含着以下信息:

像素的坐标地址 (x, y)

光照强度变化的极性

事件发生的时间戳

如下图所示,假设我们同时用DVS(图下方)和传统相机(图上方)对转动的圆盘成像, 我们就可以清晰看出区别。传统相机的成像基于采样率,所以会丢失掉帧和帧之间的信息,圆盘上黑点的运动是离散地体现在每一帧图像的不同位置上的,而当圆盘停止转动的时候,传统相机依旧会按照采样率对静态的圆盘成像。

图:传统相机+DVS相机

而对DVS而言,只有光照强度变化的像素区域才会发出事件信号,同时又没有采样率的限制,在圆盘转动的情况下,我们得到的数据输出可以看到的是一串连续的事件流。而在圆盘停止转动的时候,因为无光强明显变化,DVS相机是没有任何信号的生成的。所以对于DVS来说,它的输出脱离了采样率,对于不同的场景来说是完全不一样的。对于大体积、高速运动物体的成像可能是多的,但是对于如静止的背景,完全不产生数据。

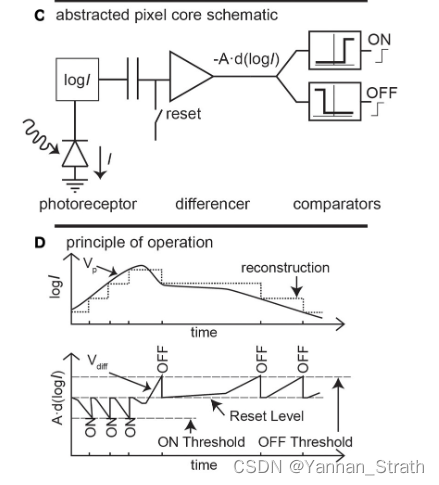

下图所示为简单的一个DVS像素工作原理。可以看出整个pipeline里由几大功能模块组成:前端的感光元件,log域计算,差分放大和比较器。其中当光强的log值在向较大方向变化时,我们得到极性为ON的事件,反之我们得到OFF事件。

图:DVS像素工作原理

点击了解:SynSense时识科技Open Neuromorphic演讲回顾:工程师共聚,探讨类脑视觉感知+计算 | 完整视频

那么DVS对于视觉传感来说能带来什么优势?

高动态范围

当拍摄的图像在光线上有巨大的差异时,更大的动态范围就能获得更大的影调空间——例如一个有明亮窗户和昏暗内部的地点。来自窗户的光线比墙壁内部的光线要亮得多,如果动态范围不够大,这时要么窗户的光线太亮,曝光过度(看起来是白色的),要么墙壁太暗,曝光不足(看起来是黑色的)。DVS的成像因为取决于光强的相对变化值,这使它在过曝光和欠曝光的状态下也能稳定清晰成像。一个DVS的理论动态范围约为120dB。而人眼的动态范围大概只在30-40dB左右。

克服成像的运动模糊

因为DVS突破了传统相机中的采样率,那么对于运动物体的成像也就不再有帧率的限制。动态模糊本质的产生原因是相机成像帧率和物体运动的速度不匹配。DVS产生的连续事件流在理论上可以等效为4000-5000FPS成像速度。目前大部分的DVS相机都可以做到us级的成像延迟,而对于一个传统30FPS的相机来说,其延时约为33ms。

超低功耗

因为DVS的异步感知和只感知光照变化强度,DVS在大部分典型视觉场景下产生的数据是极为稀疏的。大多数事件相机的功耗都在10mW的级别,有部分原型相机的功耗甚至可以做到小于10uW,这个数字远远低于传统数字相机(百毫瓦级)。

动态音频传感器

动态音频传感器DAS又称硅耳蜗(silicon cochlear),功能是把各种现实生活中的声音信号变成事件信号。和DVS一样,DAS的本身原理也是通过威廉希尔官方网站 设计将信号转换为异步的事件信号。它的发明者Shih-Chii Liu也出自上文提到的神经信息研究所INI,这个发明也带领着事件驱动传感迈向了更广阔的音频信号处理领域。Shih-Chii也因此研究获得了 [Misha Mahowald Prizes](没错, 就是为了纪念Misha在类脑领域的贡献设置的奖项)。

图:DAS功能模块

DAS实现的是在威廉希尔官方网站 层面上模仿生物听觉系统的功能,也就是从真实视觉声音激励变成电脉冲信号的过程。按笔者理解:听觉电信号的产生是因为分布在耳蜗中的内绒毛器官可以对不同强度和频率的震动产生规则的电信号,这一现象称为频率拓扑。这就很像现代数字信号处理里对声音的时频谱分析。而在DAS里,这一过程被工程化为符合频带范围的若干个带通滤波器组和半波整流器,加上一系列威廉希尔官方网站 设计和信号处理必要的模块,我们就可以实现声音信号到脉冲信号的转换。

和DVS一样,DAS的输出数据也是事件流信号的,其反应的应是一个通道内的信号能量变化强度是否超过了阈值,一个事件数据包会包含:

发出事件的通道

极性

时间戳

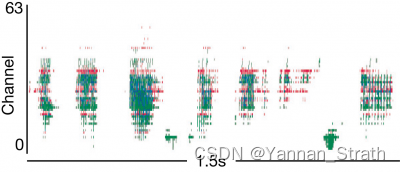

以Shih-Chii的工作为例,DAS有双声道输入,64个通道(每个声道apply32个band pass filter),两个声道的信号相互在事件上匹配,片上有数控偏置和片上麦克风,并且可以直接提供AER接口到类脑芯片上。

图:DAS响应 语句“The quick red fox jumped over the lazy dog ”

类脑传感器的应用

除了视觉和声音这两类信号,事件驱动的传感也在各个其他信号的领域被证实其可行性和高效,例如IMU、EEG、ECG信号等。那么这些新型传感器有哪些应用呢?

以DVS为例,科研学者们已经展示出了其巨大的应用前景。

DVS去模糊:比如使用DVS的信息和当前低帧率的RGB相机的信息融合,我们可以重建出一个可以输出超高帧率的低成本相机系统(去模糊)。

应用事件相机实现无人机的高速避障

复杂视觉任务:自动驾驶、机器人应用场景下的复杂任务比如SLAM, 目标识别, 光流估计等。

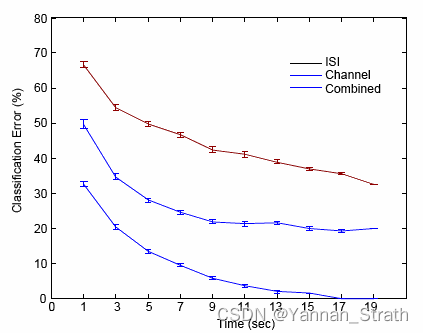

对于DAS而言,配合着相应的后端神经网络算法,我们可以做到超低功耗的各类语音任务例如:

图:Speaker verification

声源定位

通过双声道直接产生的相位差估计声源的方向和位置。

声纹识别

判断发出音频的个体。

作为整个计算的最前沿:传感效率的高低和传感信号和后端计算模式的匹配程度必然影响着整个智能系统的表现。类脑技术的完全体 = 事件驱动传感 + 异步类脑芯片计算配合着高效利用异步机制的算法。而脉冲神经网络的异步运算机制和仿生传感器天然契合,相信我们即将看到这些新兴的传感技术和计算技术出现在我们身边。

审核编辑:汤梓红

-

动态扭矩传感器的工作原理解析2020-07-24 16884

-

低成本动态倾角传感器2016-02-17 0

-

视觉传感器的工作原理、应用和选型2020-08-05 0

-

霍尔传感器在动态换挡系统中的应用解析2009-04-03 442

-

力传感器动态特性测试与性能改进2009-07-13 551

-

动态补偿智能传感器威廉希尔官方网站2009-02-12 523

-

传感器的动态特性2009-05-19 3331

-

动态测试传感器选型手册2011-01-10 361

-

OmniVision新相机传感器带来更大的动态范围2016-11-14 1123

-

视觉传感器工作原理及实际应用2018-03-01 26023

-

动态扭矩传感器应用_动态扭矩传感器安装使用2019-12-23 2851

-

传感器工作原理动态图分享2020-12-26 1565

-

事件相机的原理与应用简介2023-03-13 3031

-

37张传感器工作原理动态图分享2023-06-05 974

-

高频动态压力传感器应用案例2023-06-03 1474

全部0条评论

快来发表一下你的评论吧 !