全新NVIDIA Spectrum-X网络平台构筑阿里生成式AI云底座

描述

全新 NVIDIA Spectrum-X 网络平台构筑阿里生成式 AI 云底座。

随着生成式 AI 的热潮席卷全球,用于训练生成式 AI 的大型高性能网络基础设施开始受到客户和行业的关注。这不仅仅是因为巨大的市场潜力,更因为生成式 AI 应用对当前网络的技术与产品带来的巨大挑战。

由于生成式 AI 训练任务的特性,其对网络的要求与传统的 DC 网络在多方面存在差异。主要体现在:

性能至上,对于网络带宽及通信效率的要求高,需要实现从 GPU 到网络,再到其它 GPU 的端到端带宽平衡,从而达到充分发挥集群训练性能的目的。

AI 网络流量并发性高和突发性流量多,对于数据的完整性要求很高,依赖于 RDMA 转发保证带宽最大化和数据的完整性,降低对 CPU 资源消耗。

模型并行加数据并行共存的通信机制导致对于网络时延敏感,网络中的任何额外的时延都可能影响数以百计的 GPU 之间的通信效率。

需要无收敛的网络拓扑保证各种通信场景下的网络带宽没有瓶颈。

由于传统的网络解决方案无法满足这些需求,NVIDIA 依靠多年在 AI 和高速通信领域的积累,推出了 Spectrum-X 以太网解决方案,以推动以太网技术可以更好地适配生成式 AI 基础设施的要求。

NVIDIA Spectrum-X 是专为基于以太网的 AI 云提高性能和效率而设计的平台。

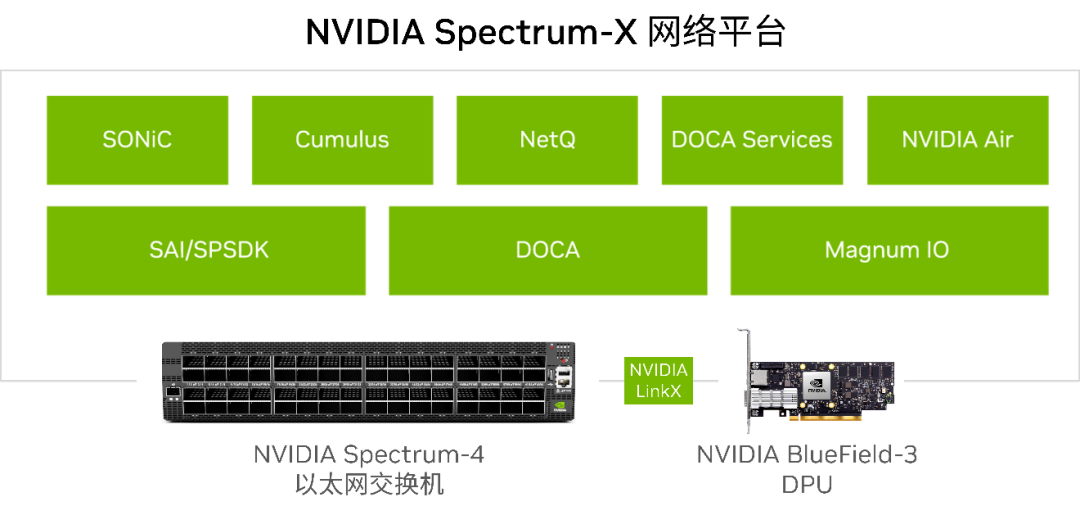

NVIDIA Spectrum-X 依托于 NVIDIA Spectrum-4 以太网交换机和 NVIDIA BlueField-3 DPU 的紧密结合,专为 AI 工作负载构建了端到端的创新网络平台,大幅提升了以太网在大规模、可扩展环境中的通信效率,并在多租户环境中实现了一致的、可预测的性能,提高了生成式 AI 云的性能和能效。NVIDIA Spectrum-X 网络平台还包括 Cumulus Linux、NetQ、Air 和 DOCA 加速软件等,以及 NVIDIA 的 LinkX 系列线缆和光模块产品,共同助力该网络平台实现出色的性能。

NVIDIA Spectrum-X 网络平台集成了 NVIDIA Spectrum-4 以太网交换机、NVIDIA BlueField-3 DPU、NVIDIA LinkX 线缆及加速软件和 SDK,通过无损以太网的端到端动态路由、基于可编程拥塞控制的性能隔离技术等先进的 RoCE 扩展功能,构建了一个专为 AI 云而优化和加速的端到端高性能 400GbE 以太网络。测试显示,与传统以太网相比,采用 NVIDIA Spectrum-X 网络平台可将大规模 AI 工作负载的性能提高到 1.7 倍,并将网络的有效通信带宽提升到 1.6 倍。

NVIDIA Spectrum-X 网络平台,实现了 GPU 到 GPU 直接的端到端加速和优化,大幅减少了大规模生成式 AI 模型的运行时间,提升了 GPU 的效率,优化了 AI 平台的总体拥有成本(TCO)和降低了基础设施的整体功耗。同时,它还具有高度的通用性,有力地支撑了各种生成式 AI 应用,由于它也是标准的以太网,实现了与已有的基于以太网堆栈的云架构和云服务互通。

阿里云作为全球领先的云供应商,拥有巨型的通用计算平台。同时,阿里云也持续向加速计算领域扩张,建成并持续扩张以“PAI 灵骏”算力服务为代表大型的 GPU 集群。阿里云基础设施网络团队从 2017 年开始构建端网融合的可预期高性能 RDMA 网络架构,过去几年已经在高性能存储领域实现了大规模部署,目前正在大规模 AI 计算领域持续创新迭代和规模部署,以适配 AI 计算对高性能网络的诉求。阿里云也充分认识到技术创新对以太网方案持续支持高性能网络,尤其是生成式 AI 基础设施的重要性。

为此,阿里云联合 NVIDIA 对 Spectrum-X 解决方案进行测试,以评估新技术对高性能网络的适应能力。

测试的主要内容和结果

阿里云测试环境配置

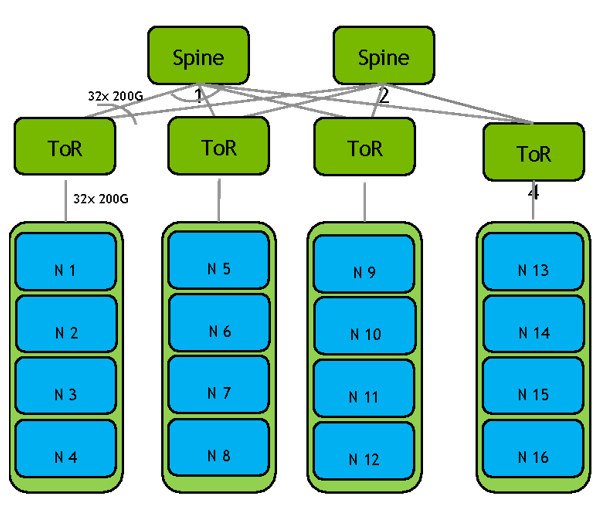

测试环境使用了 2 台 Spine 交换机,4 台 ToR 交换机,16 台 HGX GPU 服务器并配置了 NVIDIA BlueField-3 DPU,基于 NVIDIA 51.2T Spectrum-4 交换芯片的 SN5600,以太网交换机,支持 128*400G 或者 64*800G 端口。每台 GPU 服务器配置 8 张 BlueField-3 DPU,每 4 台 GPU 服务器为一组连接到一台 ToR 交换机,共 4 组连接到 4 台 ToR 交换机。ToR 交换机通过 200G 网络连接到 BlueField-3 DPU,4 台 ToR 交换机通过 2 台 Spine 交换机连接在一起,构成无阻塞胖树网络。

主要的测试内容

这些测试由多个级别的工作负载组成,从简单到复杂:

RDMA 基准性能测试,覆盖带宽和延迟。

孤立场景下的 All to All 和 All Reduce 集合通信测试,专注于 NCCL 性能基准。

在共享资源和有背景噪声环境下的性能测试。

故障场景的测试。

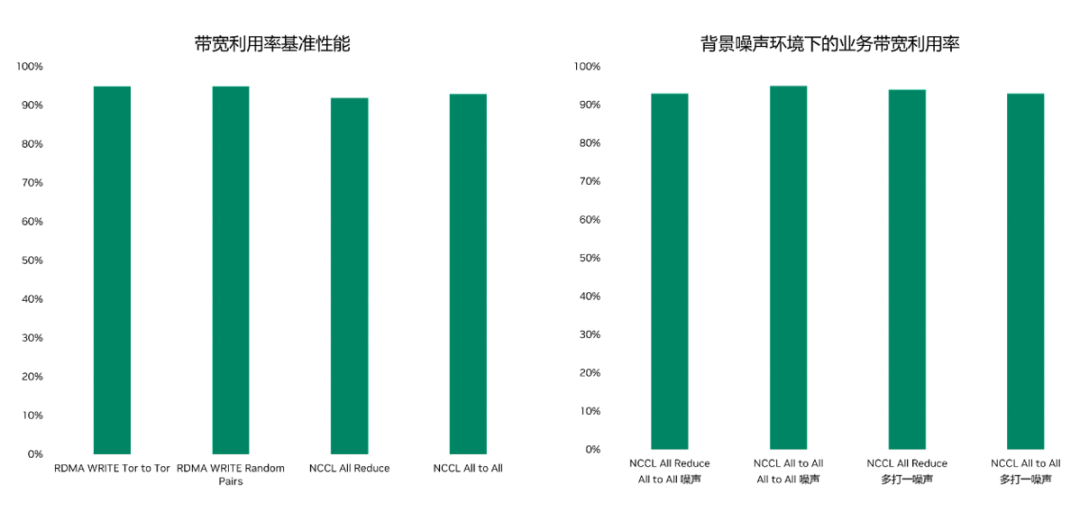

测试结果显示,由于使用了端到端的逐包负载均衡优化技术(Adaptive Routing)和零配置 RoCE 拥塞控制(ZTR CC)使得网络利用率显著提升,并显著减少由于网络拥塞和 In-Cast 问题带来的时延和抖动。网络带宽利用率在各种测试场景下均可超过 90%。这种逐包负载均衡技术也可以对多种故障情况(本端和远端)做出响应,合理地利用网络内的带宽资源。在真实训练任务的测试过程中,Spectrum-X 可以降低 20% 以上的训练时间。在获得这一切收益的同时,网络的配置工作量大大降低,运维人员不再需要进行复杂的配置和频繁的调优工作。

这些测试结果表明 NVIDIA Spectrum-X 加速网络平台的突破性技术可大幅提升大规模生成式 AI 工作负载的性能,并大幅缩短生成式 AI 模型的运行时间。

通过采用 NVIDIA Spectrum-X 网络平台,客户可进一步为千行百业的客户提供具有性能和成本优势的生成式 AI 云服务,将 AI 通用大模型和行业大模型赋能和融合各种应用场景。NVIDIA 和阿里云的开发人员将基于 NVIDIA Spectrum-X 网络平台的加速软件和 SDK 进一步在虚拟化、定制化可编程拥塞控制、遥测、快速故障响应等方面展开合作,推动这一新解决方案的进一步发展和应用。

针对这一联合测试,阿里云基础设施网络研发事业部总经理蔡德忠表示:“高性能网络技术是 AI 计算 Scaling Law 的关键所在,这个领域需要持续不断的创新迭代,阿里云始终坚持网络的开放性,也是网络开源生态的领导者和积极贡献者,阿里云与 NVIDIA 在 AI 计算和高性能存储领域合作多年,将持续探索创新基于 Open Ethernet 的高性能网络方案,助力 AI 计算集群的大规模高效扩展。”

NVIDIA 网络高级副总裁 Gilad Shainer 表示:“生成式 AI(Generative AI)是面向下一代业务需求的典型代表,为了支撑成千上万的用户的需求,生成式 AI 云需要先进及可靠的网络基础架构满足各种 AI 业务的平滑增长。阿里云和 NVIDIA 在 Spectrum-X 以太网平台上的策略合作,可以充分利用 Spectrum-X 的先进路由技术和云上业务性能隔离技术,使阿里云及其广大用户可以尽情享受生成式 AI 的服务。”

审核编辑:刘清

-

NVIDIA Spectrum以太网平台的自适应路由技术2022-07-10 1363

-

GTC23 | NVIDIA 携手谷歌云提供强大的全新生成式 AI 平台,基于新款 L4 GPU 和 Vertex AI 构建2023-03-23 602

-

COMPUTEX2023 | NVIDIA 推出面向超大规模生成式 AI 的加速以太网平台2023-05-30 512

-

阿里云与 NVIDIA 合作测试以太网络新架构2023-11-01 362

-

NVIDIA 人工智能开讲 | 什么是 Spectrum-X 网络平台?2023-11-06 794

-

戴尔科技、慧与和联想即将推出 NVIDIA 全新 AI 以太网络平台2023-11-21 245

-

NVIDIA全新AI以太网络平台大幅提升AI云性能2023-11-27 815

-

NVIDIA 发布全新交换机,全面优化万亿参数级 GPU 计算和 AI 基础设施2024-03-19 334

-

NVIDIA AI Enterprise荣获金奖2024-05-29 449

-

NVIDIA Spectrum-X 以太网网络平台已被业界广泛使用2024-06-03 970

-

应用NVIDIA Spectrum-X网络构建新型主权AI云2024-07-26 1182

-

NVIDIA新增生成式AI就绪系统认证类别2024-10-10 372

-

NVIDIA 以太网加速 xAI 构建的全球最大 AI 超级计算机2024-10-30 153

-

NVIDIA推出全新生成式AI模型Fugatto2024-11-27 353

全部0条评论

快来发表一下你的评论吧 !