芯片设计中DRAM类型如何选择

存储技术

描述

选择越多,选择越难。

芯片制造商开始将多种类型和风格的 DRAM 整合到同一个先进封装中,为日益分布式的内存但更加复杂的设计奠定了基础。尽管多年来预测 DRAM 将被其他类型的内存取代,但它仍然是几乎所有计算中的重要组成部分。它的足迹非但没有消失,反而在增加,选择的数量也在增加。

有几个因素推动了这种扩张。

首先,系统中计算元素的数量和密度不断增加,以更快地处理更多数据,特别是对于人工智能/机器学习和数据中心应用程序。更多的核心需要更多的内存,因为需要有一个地方来存储数据并处理数据。

其次,通常情况下,大部分数据都会在缓存中处理,而 SRAM 一直是 L1 到 L3 缓存的首选内存。但 SRAM 的扩展速度不再与数字逻辑相同。因此,它在芯片上占用了更大的空间,并且 DRAM 速度的提高使得某些类型适合 L3 缓存。

最后,来回移动数据移动受到带宽和距离的限制,因此仅在一个物理位置添加更多内存并不一定会提高性能。事实上,它可能会起到相反的作用。

由于这些原因,芯片制造商正在使用更多的 DRAM。在某些情况下,DRAM(尤其是HBM)正在取代一些 SRAM。DRAM 拥有久经考验的耐用性记录以及成熟的工艺,而且比 SRAM 便宜得多。Objective Analysis 总经理 Jim Handy 表示,根据原始数据,相同容量的 SRAM 成本可能比 DRAM 高出 2,500 倍以上,具体取决于 DRAM 的类型。

当然,DRAM有多种类型可供选择。有些速度非常快,如HBM,但也很昂贵。其他类型速度较慢,但价格便宜,如基本的DDR DIMM。然而,变化的是,在异构架构中,两者都可以发挥重要作用,以及多种其他DRAM类型和更狭义的存储器,如MRAM或ReRAM。

“我们正在考虑更多的混合模型,在同一系统中使用不同的 DRAM 技术,”Cadence 高级技术营销经理 Kos Gitchev说。“如果您确实需要非常高的性能,并且愿意为此付费,那么您可能会选择 HBM。您可以将其用于 L3 缓存,或者您需要立即访问的任何其他内容。如果您仍然需要更多内存,但延迟稍长,则可以在RDIMM(注册双列直插内存模块)或 MRDIMM (多路复用器级 DIMM)中使用 DRAM。如果您正在寻找大容量,那么您可能会考虑CXL后面的 DRAM。该技术开始针对非常具体的应用程序,具有真正的高带宽和低功耗、更大的内存占用,但延迟稍多。将所有这些混合在一起是每个人解决这些问题的方向。”

与先进节点或先进封装的几乎每一项改进一样,解决一个问题可能会导致另一个问题。尽管如此,基本理论是合理的,并且当今市场上也有证据。例如,保持某些功能(例如人工智能)以最大速度运行可能至关重要,这将使高带宽内存成为最佳选择。但并非所有功能都是必需的,并且它们并不都需要这种级别的性能。在某些情况下,GDDR5 或 GDDR6 可能就足够了。在其他情况下,可能是 LPDDR,在其他情况下可能是 DDR4。所有这些都有不同的成本,这些成本可以用来回移动数据的资源以及存储芯片的货币价值来衡量。

另一方面,并不是所有的DRAM都是一样的,在没有充分了解不同类型的 DRAM 会如何影响其他组件的情况下,仅添加不同类型的 DRAM 可能会导致问题。重要的是要以避免未来问题的方式将它们集成起来,这包括复杂的布局规划,以避免信号完整性和防止热问题。众所周知,DRAM和散热不太好。但也有一堆以前从未认真考虑过的新问题。

“DRAM 向前发展的重大问题分为两类——常见的问题(更多的带宽和容量、管理功率)和一些新的问题(更具挑战性的可靠性,这导致了片上 ECC 和 RowHammer 保护等问题), ” Rambus的杰出发明家 Steven Woo 说道。“为了应对新的挑战,在芯片上放置更多的电容器会增加片上错误的发生,因此今天的 DRAM 在数据返回到控制器之前会进行一定量的片上错误纠正。像 RowHammer 这样的相邻单元干扰问题的发生是因为这些单元彼此非常接近,访问一组单元可能会导致邻近单元的位翻转。”

什么地方最有效

选择的数量不断增加,也让我们很难决定使用哪些存储器。通常根据性能、功耗、成本、可靠性(纠错码以及经过全面测试和供应链安全)和容量来选择 DRAM。因此,如果 DRAM 将用于 L3 缓存,则可能需要高性能和低功耗。如果要用于高级封装中的低级功能,则它可能是标准 DIMM。

但这些选择中的每一个也会影响整体芯片或系统级封装设计,并伴随着特定的设计考虑。

“过去,DDR4 和 LPDDR4 并没有那么复杂,”Synopsys 产品营销高级经理 Graham Allan表示。“一个客户将启用 DDR4,另一个客户将启用 LPDDR4,并且存在重叠。随着我们进入 DDR5 和 LPDDR5 及更高版本,这些应用空间确实发生了分化,接口协议和物理信令也发生了变化。DDR5 通常需要与大量 DRAM(大容量)通信,因此您主要与寄存器 DIMM 连接。使用 LPDDR,您通常会与一个封装或设备通信,并且该设备中最多有两个负载。LPDDR 也是接地端接的。DDR 端接到正电压轨。这些是非常不同的物理接口和协议,这意味着客户需要选择其中之一。”

还有一些中间选项可以帮助在多个应用程序中使用相同的设计。例如,MRDIMM 可用于将容量加倍或将带宽加倍,具体取决于工作负载。“多路复用器级 DIMM 的容量和速度是 SDRAM(同步 DRAM)的两倍,”Allan 说。“它的美妙之处在于 DRAM 不会改变。它以两种不同的模式运行。它的运行方式类似于负载减少的 DIMM,但速度不会加倍。这将是一种使用它来获得更高容量的模式。或者它以多路复用排序模式运行,这使得 DRAM 和外部接口之间的带宽加倍。”

这是图片的一部分。另一部分是 PHY,即物理层,它提供与内存的物理接口。PHY 因所使用的 DRAM 类型而异,随着数据量的增加和设计变得越来越异构,它们变得尤为重要。

PHY 还可以链接在一起形成一种主堆栈,以便管理复杂设备中的内存资源,无论是 GDDR6 还是 LPDDR4。这样,所有类型的 DRAM 都可以被视为可用资源并进行集中管理。

“通过某种类型的结构来管理带宽,所有内容都是可见且可寻址的,”瑞萨电子基础设施业务部公司副总裁兼总经理 Balaji Kanigicherla 说道。“这不仅仅是提高密度或存储器的物理原理,这是材料科学。存储器的应用架构是产业发展的方向。密度需要提高,因为您希望在相同的带宽下获得更多的容量。我们可以根据每美元或每 GB 的路径进行混合和匹配,并且可以在 SSD、DRAM 和本地片上 SRAM 缓存之间使用分层。这正在转向整个系统的 TCO,并考虑我们将为每一层支付的成本。”

这本质上提高了内存管理的抽象级别。Kanigicherla 表示:“您可以从当前模型发展到在全球范围内解决内存问题,并基本上创建足够有效的互连来管理缓存或减少延迟。” “这就像全局可寻址内存的一个分区。显然,您需要提供带宽。但好消息是,对于人工智能工作负载,它们对延迟的敏感度稍低,对带宽的敏感度更高。所以你可以利用这项技术来扩大规模。在 CXL 和 UCIe 之间,应该有一种更渐进的方法来分解存储器,可能包括光学互连,并实现存储器的完整全局视图。但这需要整个行业的努力才能实现。这并不简单。”

内存池是另一种选择,并且在数据中心中越来越受欢迎。内存池对于 DRAM 的作用就像超扩展对于处理器核心的作用一样。当需要额外的内存时,可以像使用额外的计算核心一样使用它,通常是通过 CXL 接口。

Rambus 说:“池化背后的想法是,如果我有一组服务器,并且每台服务器都有内存,那么每台服务器不太可能同时使用所有内存容量。” Woo 最近在CASPA活动中的一次演讲中说道。“更有意义的是将其中一些容量放入外部机箱中,并将其视为池资源。当处理器需要的内存超过机箱内的内存时,它们可以在短时间内检查并配置一些内存,将其用于计算,然后将其返回到池中。这是让很多业内人士兴奋不已的新功能之一。更远一点,一旦你做了这些类型的事情,你就可以开始考虑通过交换机附加内存和池。CXL标准还允许多级切换。这种灵活性将有助于提高各种应用程序的性能和总拥有成本。”

其他存储方法

除了更传统的方法之外,DRAM 还向多种方向发展。部分原因是转向异构集成和高级封装以及更多特定领域的设计,部分原因是更接近数据源进行处理的好处。

“与计算和 DRAM 相比,我们使用 17% 的能量进行计算,并使用 63% 的能量将数据从一个点移动到另一个点,”Siemens Digital Industries Software 的内存技术专家 Jongsin Yun说道。“这是大量的能量。我们可以节省这一点并提高速度和电源效率。当前的解决方案是向缓存中添加更多内存,但这是一个昂贵的解决方案。我们不需要将所有数据移动到 DRAM。我们可以在内存中进行一些计算,或者使用一些基于 GPU 的 AI 卷积,这样我们就可以在不进行内存传输的情况下进行计算。”

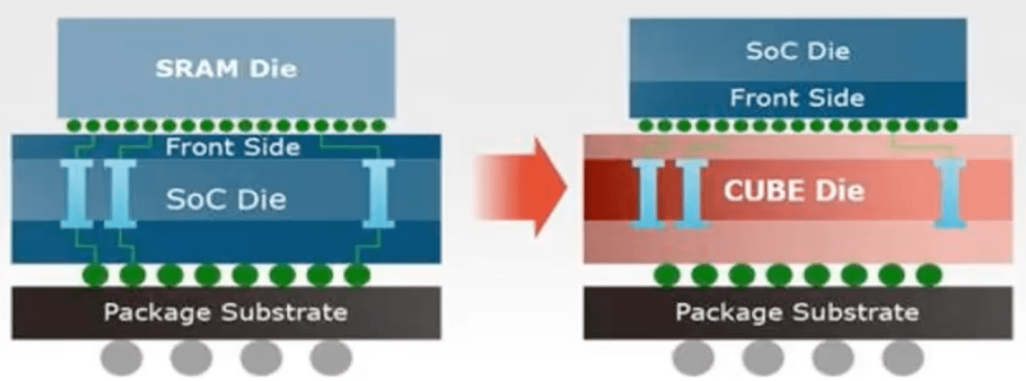

今天的选择比以往任何时候都多,而且还有更多的选择处于开发阶段。例如,华邦电子开发了几种基于 DRAM 的内存解决方案,但超越了经典的 DRAM 使用模型。一是该公司的单芯片CUBE(定制超带宽元件)架构。另一种是伪静态 DRAM,它介于 SRAM 和 DRAM 之间,无需外部数据重写。这两者都针对特定市场,例如可穿戴设备和边缘服务器。

“现在最热门的话题是生成式人工智能,”华邦电子美国公司营销主管 CS Lin 说。“但是数据中心发生的情况与我们关注的地方有不同的要求,而且密度也有很大不同。我们专注于 16 GB/秒及以下的密度,但该解决方案可扩展到 256 KB/秒。它的运行速度非常接近 HBM2 带宽,但具有功耗极低的优势。”

CUBE 方法,延迟约为 25 纳秒,单位密度比 14 纳米 SRAM 高 5 倍。来源:华邦电子

Lin 表示,这种方法的好处是能够使用标准 DRAM 来提高性能,而不是依赖最先进的工艺节点。通常,较高的密度会产生延迟,但 CUBE 架构使用数千个硅通孔来移动数据,并根据更多带宽或更高速度的需求灵活分配这些通孔。这允许更细粒度的系统架构,以及更小的占地面积。

另一种方法是均衡。这个计划已经酝酿了一段时间,但似乎终于获得了关注。“均衡可以改善您在通道末端接收到的数据,”Synopsys 的 Allan 解释道。“简单来说,这就像符号间干扰。当一系列比特通过通道传输时,当一个比特完成时,它实际上已经进入下一个比特的时域。信号上升和下降以及从 1 到 0 的切换需要比一个单位间隔更长的时间。你并不是从稳定的低潜力状态开始的。你是从一个更高的状态开始的。使用决策反馈均衡来偏移输入接收器中的采样点。那么我现在如何优化我的输入接收器,以便对一和零检测具有相似的余量?我并没有真正感觉到有什么东西可以将参考电压精确地放在中间。”

内存计算也即将出现。虽然已经有几种使用 MRAM 的商业方法,但普林斯顿大学的研究人员在 2019 年的一篇论文中展示了 FPGA 中的外部 DRAM 控制器,可以与现成的 DRAM 一起使用来创建大规模并行计算。研究人员声称,这种方法克服了所谓的内存墙,即逻辑性能已经超过了内存带宽。

权衡

那么,与DRAM相比,SRAM的使用量是多少?对此没有简单的公式,因为这不是同类比较。

Flex Logix首席技术官兼联合创始人 Cheng Wang 表示:“确实没有什么神奇的方法可以做到这一点。”我们的大部分设计权衡来自于对 SRAM 带宽、SRAM 容量和 DRAM 带宽进行建模的性能估计。这是我们的三个主要旋钮。基本上,我们有四种标准的计算规模,为我们的标准 IP 产品提供不同数量的 SRAM 和 DRAM 带宽。这是基于我们运行模型的经验数据来确定哪种效果更好。如果我们有 2 倍的 SRAM 容量,某些模型可以运行得更好。如果您可以通过将 SRAM 加倍来使性能几乎翻倍,并且再用 20% 的面积来实现 2 倍的性能,那就太好了。但还有很多其他型号无法从额外的 SRAM 中受益,那么您就白白添加了该区域。这就是为什么进行周期准确的性能估计很重要。在我们的例子中,它的精确度不能精确到单个周期,但可以精确到 8%,这超出了我们的需要。然后,您可以对适当的 SRAM/DRAM 计算权衡进行大量架构分析,这可能因工作负载类型而异。”

这是复杂的数学,并且随着系统被分解为异构元素(例如小芯片),它变得更加复杂。“SRAM 每一位需要更多晶体管才能实现。它比 DRAM 密度更低、更昂贵,并且在读取和写入过程中具有更高的功耗。” Ansys首席产品经理 Takeo Tomine 说道。“目前,SRAM 是在 CPU 通常设计的先进 finFET 技术节点上设计的,而 finFET 器件由于器件的热阻较高,更容易产生热效应(自热)。”

在某些情况下,使用什么类型的内存以及在何处使用它可能取决于设备的预期使用寿命。“有两个主要的可靠性问题会导致存储器的寿命缩短,”Tomine说。“其中之一是,互连可靠性与技术节点缩小会导致存储器的使用寿命缩短,因为自热会导致严重的电迁移(EM),这是最关键的可靠性问题之一。材料和工艺技术以及技术扩展不断提高电磁寿命。其次是不同架构的设备带来的可靠性挑战。在将器件架构从 finFET 转移到纳米片再到 CFET 的过程中,热阻急剧增加,这意味着器件通道的 Delta T 值更高。器件自热将与金属焦耳热耦合。器件的自热会影响栅极氧化物击穿(时间相关的电介质击穿),并且还会降低 HCI(热载流子注入)性能,从而使器件的 BTI(偏置温度不稳定性)恶化。”

可靠性是衡量存储设备在给定时间内无故障运行的能力的指标。智能手机的预期寿命为 4 年,而汽车、军事或金融服务器应用的预期寿命为 10 至 15 年(或更长),这一时间范围可能非常不同。能够理解可能影响存储器寿命的潜在相互作用至关重要,它们可能因架构、存储器类型和使用情况而异。

这也会影响使用哪种内存以及整个系统架构。因此,如果记忆可以被替换,那么与将这些记忆嵌入某种类型的高级封装中并密封起来相比,寿命就不那么重要了。“这就像拥有一个 DRAM卡池,现在就可以升级,”瑞萨电子的 Kanigicherla 说道。“使用 HBM,如果出现问题,你将无能为力,因此你将扔掉非常昂贵的芯片。在CPU方面,服务器之间的联系非常紧密,你无法做太多的事情来升级任何东西。这就是全局共享内存概念起作用的原因。其中一些解决方案是自动出现的。”

延迟增加了另一个权衡。“特别是使用 HBM,可以将处理器和 DRAM 非常紧密地结合在一起,”Cadence IP 集团产品营销总监 Frank Ferro 说道。“这样做有很多好处。HBM 一直在快速发展。我们几乎每两年就会看到性能的改进。所以这条曲线很陡。但从系统设计的角度来看,2.5D仍然是一个挑战。优化中介层并帮助客户设计这确实是对话的关键部分。”

结论

自 1967 年发明以来,DRAM 一直是计算的关键。尽管多年来无数存储技术对其提出了挑战,但没有任何技术可以取代它。鉴于围绕这项技术的狂热活动,在可预见的未来没有任何东西可以取代它。

DRAM 现在不再是一种类型,而是有多种类型,并且每种类型都在不断发展并催生新的想法。从内存到处理元件的物理连接,到服务器机架外部的内存池,各个层面都有创新。目前正在努力缩短信号在内存和处理器内核之间传输的距离,这将减少移动数据所需的功耗以及每个周期所需的时间。

从长远来看,DRAM 仍然是一个充满活力和创新的领域,并且即将出现更多的创新和不同的方式来组合内存解决方案,这些解决方案可以对性能、成本、可靠性和寿命产生重大影响。

编辑:黄飞

-

DRAM原理 - 1.存储单元阵列#DRAMEE_Voky 2022-06-28

-

DRAM原理 - 6.猝发模式与内存交错#DRAM原理EE_Voky 2022-06-28

-

DRAM原理 - 7.地址映射#DRAM原理EE_Voky 2022-06-28

-

【内存知识】DRAM芯片工作原理2010-07-15 0

-

DRAM存储原理和特点2020-12-10 0

-

LPDDR5 DRAM芯片的性能及应用是什么?2021-06-26 0

-

单片机资料下载选择芯片类型2021-11-19 0

-

DRAM芯片中的记忆单元分析2022-03-02 0

-

关于PLC输出类型的选择及使用中的注意事项2009-06-20 1312

-

DRAM储存器有哪些类型如何设计DRAM控制器2020-10-31 4264

-

JEDEC定义了四种主要类型的DRAM2022-09-26 3807

-

IC设计中的封装类型选择2023-04-03 1213

-

DRAM选择为何突然变得更加复杂?2023-11-22 992

-

DRAM芯片的基本结构2024-07-26 1078

-

贴片电感使用类型如何选择?2024-08-07 318

全部0条评论

快来发表一下你的评论吧 !