Pytoorch轻松学 – RetinaNet自定义对象检测

描述

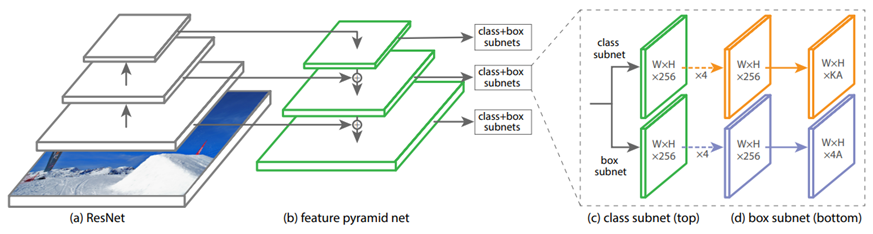

RetinaNet网络介绍

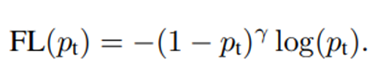

2017发布,实现了一阶段网络首次在精度方面超过二阶段网络的经典网络,作者最大的一个创新就是在训练损失函数方面,论文比较了CE、BCE、以及论文提出感知损失函数(FL),最后说明感知损失可以有效解决一阶段网络训练中的样本不平衡现象,从而取得更佳的训练效果。论文中提出的感知损失函数如下:

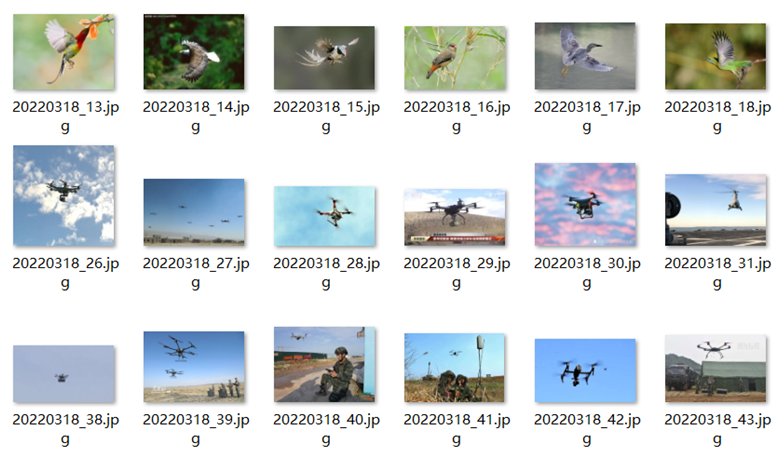

数据集准备与制作

自己百度收集了一个无人机与飞鸟的数据集,其中训练集270张图像,测试集26张图像。

使用labelImg工具完成标注,工具下载地址:

https://gitee.com/opencv_ai/opencv_tutorial_data/tree/master/tools

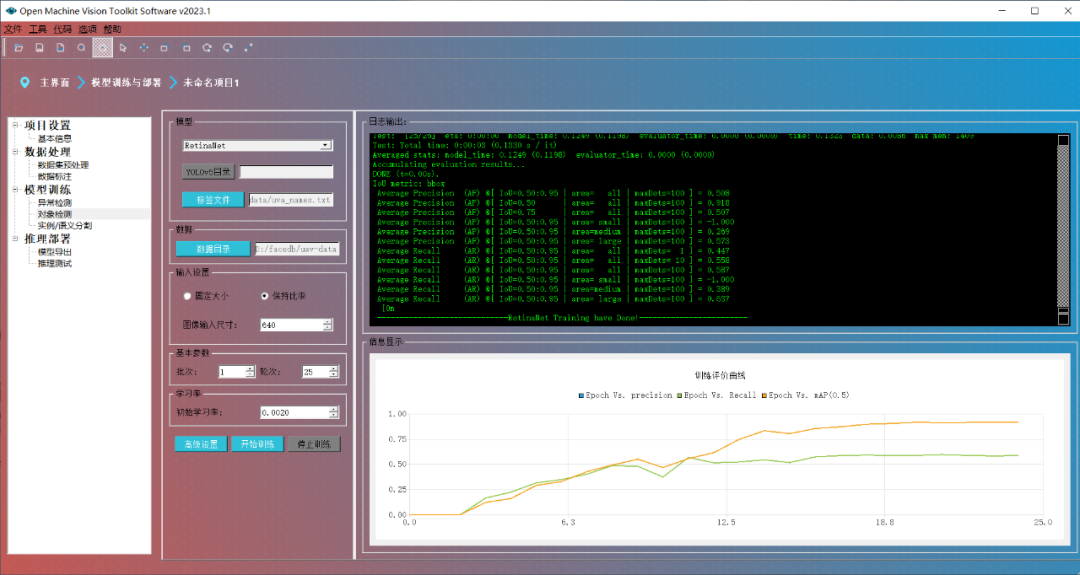

三:模型训练

制作好数据集之后,模型训练就成为一件很简单事情,基于OpenMV工具软件,零代码即可实现模型训练。运行下面界面如下:

model = tv.models.detection.retinanet_resnet50_fpn(pretrained=True)

dummy_input = torch.randn(1, 3, 1333, 800)

model.eval()

model(dummy_input)

im = torch.zeros(1, 3, 1333, 800).to("cpu")

torch.onnx.export(model, im,

"retinanet_resnet50_fpn.onnx",

verbose=False,

opset_version=11,

training=torch.onnx.TrainingMode.EVAL,

do_constant_folding=True,

input_names=['input'],

output_names=['output'],

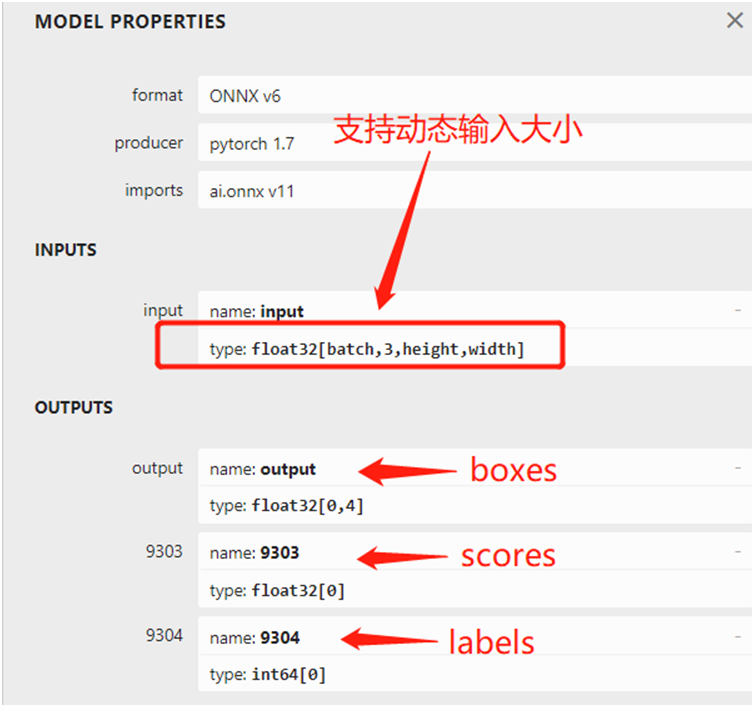

dynamic_axes={'input': {0: 'batch', 2: 'height', 3: 'width'}}

)

运行时候控制台会有一系列的警告输出,但是绝对不影响模型转换,影响不影响精度我还没做个仔细的对比。

模型转换之后,可以直接查看模型的输入与输出结构,图示如下:

推理运行

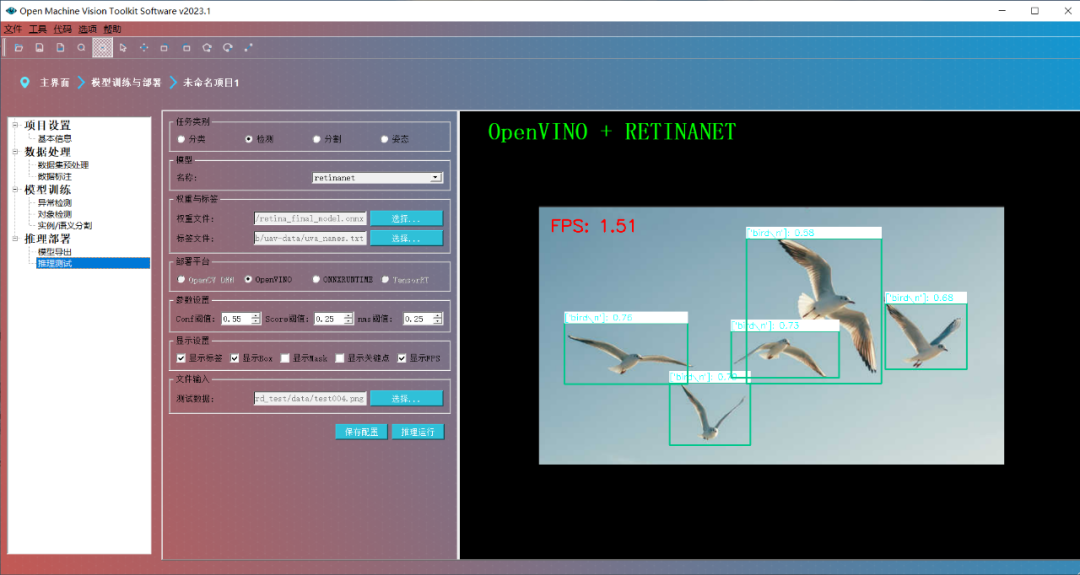

推理部分的代码很简单,只有三十几行,Python就是方便使用,这里最需要注意的是输入图像的预处理必须是RGB格式,需要归一化到0~1之间。对得到的三个输出层分别解析,就可以获取到坐标(boxes里面包含的实际坐标,无需转换)。基于OpenMV工具软件,可以实现一键零代码推理演示,效果如下:

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

苹果新版Reality Converter应用可自定义3D对象2020-01-14 2243

-

自定义函数测试学习工程2010-07-01 464

-

1602自定义字符2016-01-20 755

-

JAVA教程之自定义光标2016-03-31 578

-

PDH网管盘 自定义字节2016-12-26 958

-

基于自定义特征的飞机结构件智能检测规划技术_曾德标2017-02-08 546

-

如何在android设备上安装自定义rom2019-11-05 5172

-

自定义视图组件教程案例2022-04-08 617

-

ArkUI如何自定义弹窗(eTS)2022-08-31 2232

-

基于AI自定义视觉工作场所安全检测系统2022-12-09 394

-

用于改进应用的自定义逻辑外设2023-05-06 952

-

labview自定义控件2023-05-15 711

-

自定义神经网络对象识别开源分享2023-06-16 183

-

自定义算子开发2022-04-07 2824

-

labview超快自定义控件制作和普通自定义控件制作2023-08-21 500

全部0条评论

快来发表一下你的评论吧 !