大模型时代必备存储之HBM进入汽车领域

存储技术

描述

大模型时代AI芯片必备HBM内存已是业内共识,存储带宽也成为AI芯片仅次于算力的第二关健指标,甚至某些场合超越算力,是最关键的性能指标,而汽车行业也开始出现HBM内存。

图片来源:SK Hynix

SK Hynix是全球最大的HBM内存厂家,也是全球唯一量产三代HBM内存厂家,同时也是全球唯一量产车载HBM内存厂家。

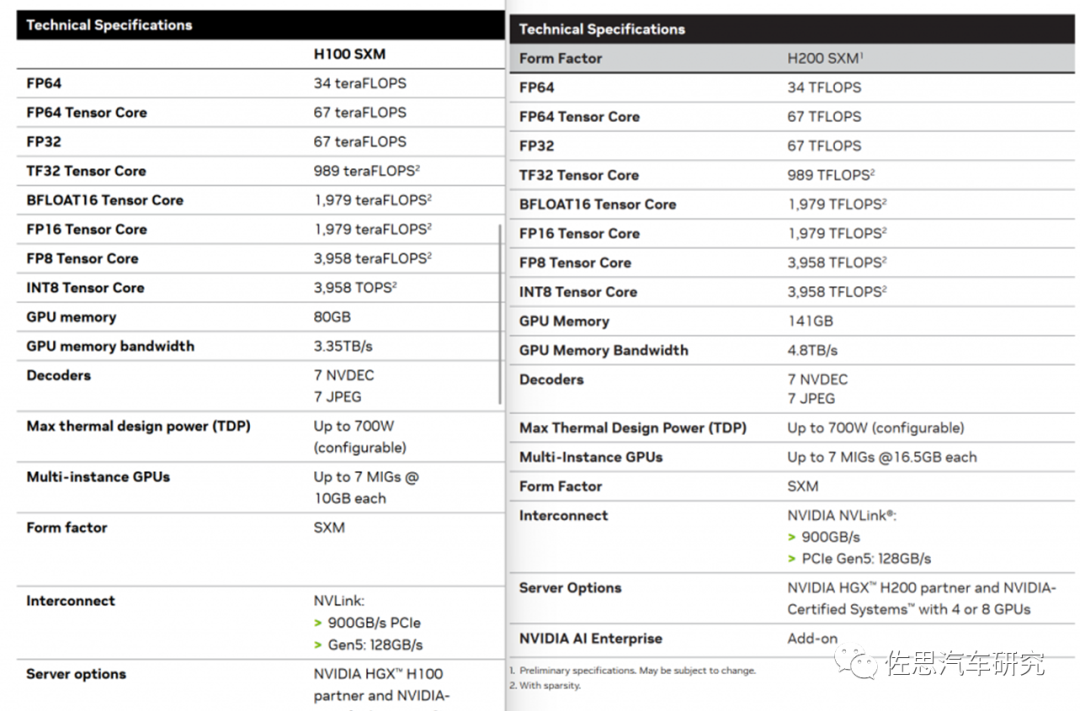

2023年11月13日,英伟达推出H100的升级版H200,实际只是升级了HBM内存,其余GPU部分丝毫未变。

H100和H200的参数对比

图片来源:NVIDIA

H100和H200算力完全一致,只是内存由原来的80GB HBM3升级为141GB HBM3E内存。存储带宽由3.35TB/s提高到4.8TB/s。

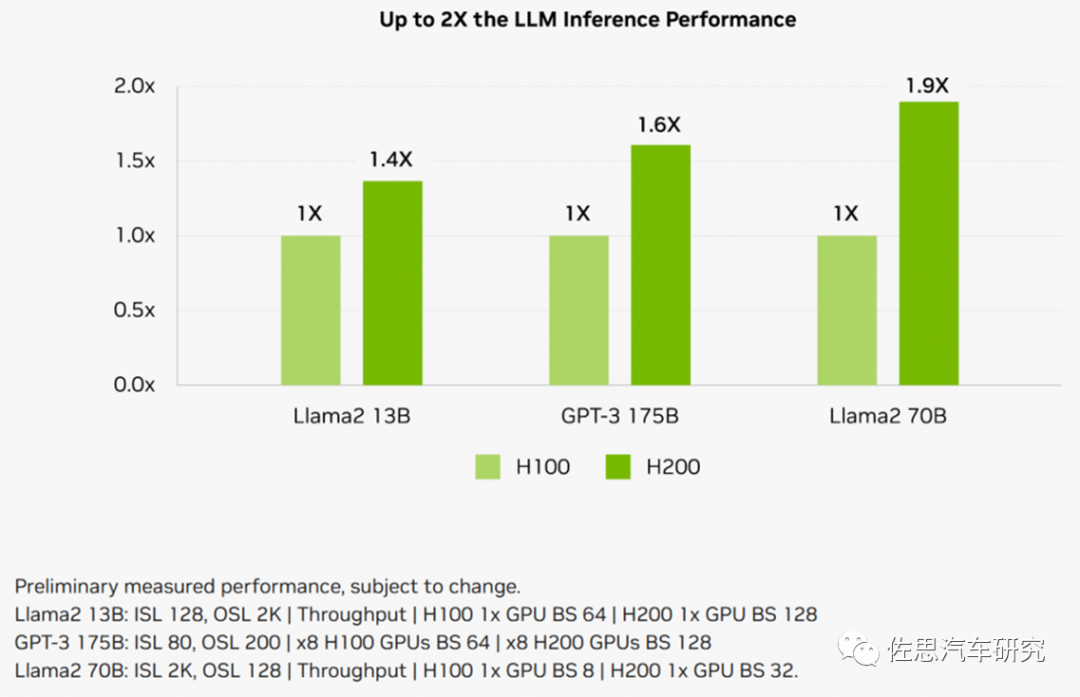

图片来源:NVIDIA

增加存储带宽后,推理性能大幅提升,最高提升近两倍。一般来说集群的推理算力不是瓶颈,而是被显存带宽和单个GPU显存大小给卡着。比如一旦出现跨GPU的互联,虽说有NVLink,但跨卡通信速度900GB/s和单个GPU内部的4.8TB/s也差了一个数量级。单个GPU的显存容量提升至141GB后,跨卡访问的次数也就减少了。性能自然显著提升。

全球主要AI芯片使用HBM情况

(完整内容请参见《佐思汽车新四化每周观察》12月第1期)

可以说判断是否为AI芯片的关键就是是否具备HBM内存。

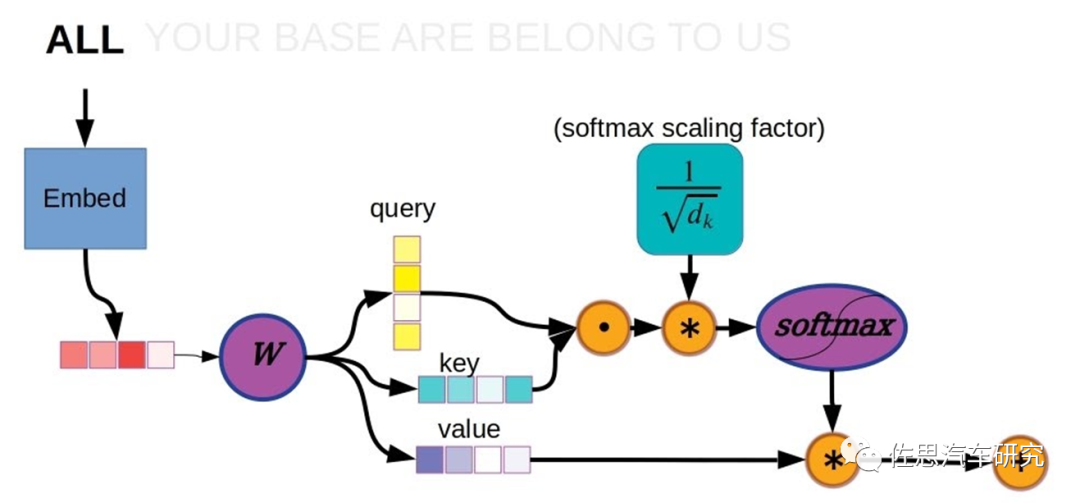

Transformer的计算过程

以上是Transformer的计算过程,在这个计算过程中,矩阵乘法是典型的计算密集型算子,也叫GEMM,即通用矩阵乘法。存储密集型算子分为两种,一种是矢量或张量的神经激活,多非线性运算,也叫GEMV,也就是通用矩阵矢量乘法。另一种是上面说的逐点元素型element-wise。

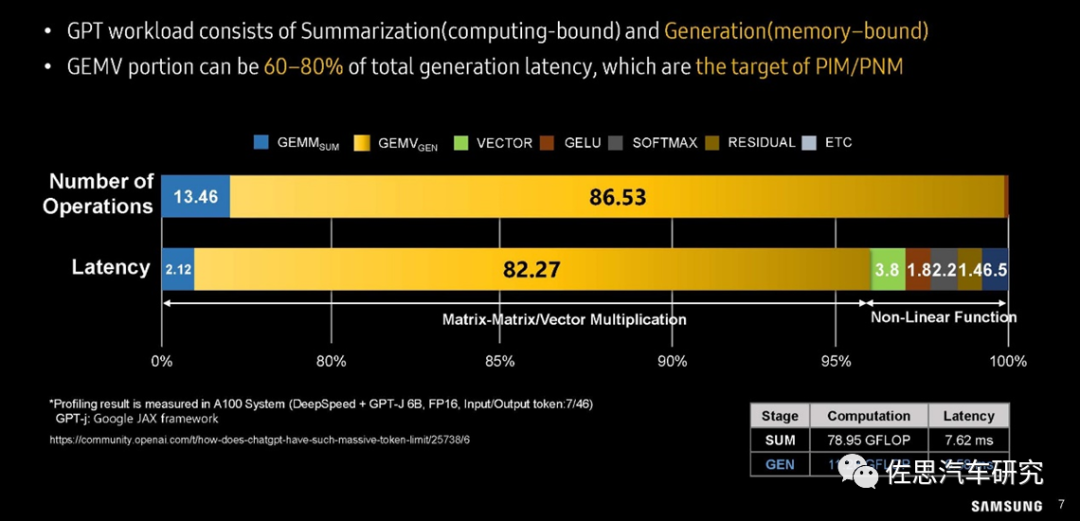

三星对GPT大模型workload分析

图片来源:三星

在运算操作数量上,GEMV所占的比例高达86.53%,在大模型运算延迟分析上,82.27%的延迟都来自GEMV,而GEMM只占2.12%,非线性运算也就是神经元激活部分占的比例也远高于GEMM。

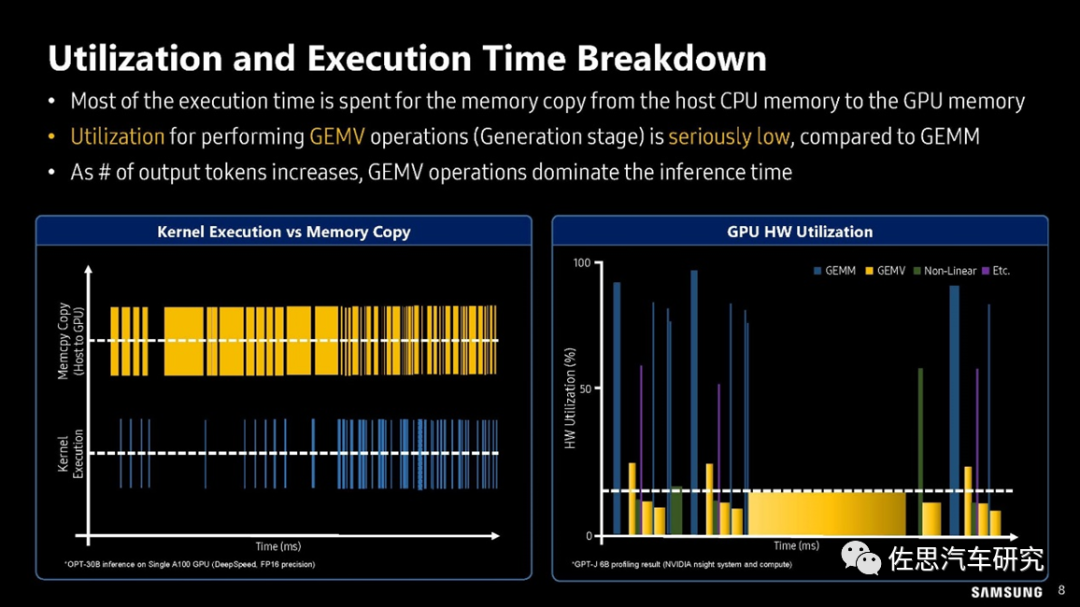

三星对GPU利用率的分析

图片来源:三星

上图可以看出在GEMV算子时,GPU的利用率很低,一般不超过20%,换句话说80%的时间GPU都是在等待存储数据的搬运。还有如矩阵反转,严格地说没有任何运算,只是存储行列对调,完全是存储器和CPU在忙活。解决办法很简单且只有一个,就是用HBM高宽带内存。

常见汽车内存性能与价格对比

(完整内容请参见《佐思汽车新四化每周观察》12月第1期)

上表为常见汽车内存性能与价格对比,显然,一分价钱一分货。英伟达H100是HBM3的最大采购者,每GB的采购价格大约14美元。还有一点需要指出,目前没有车规级GDDR6存储芯片。

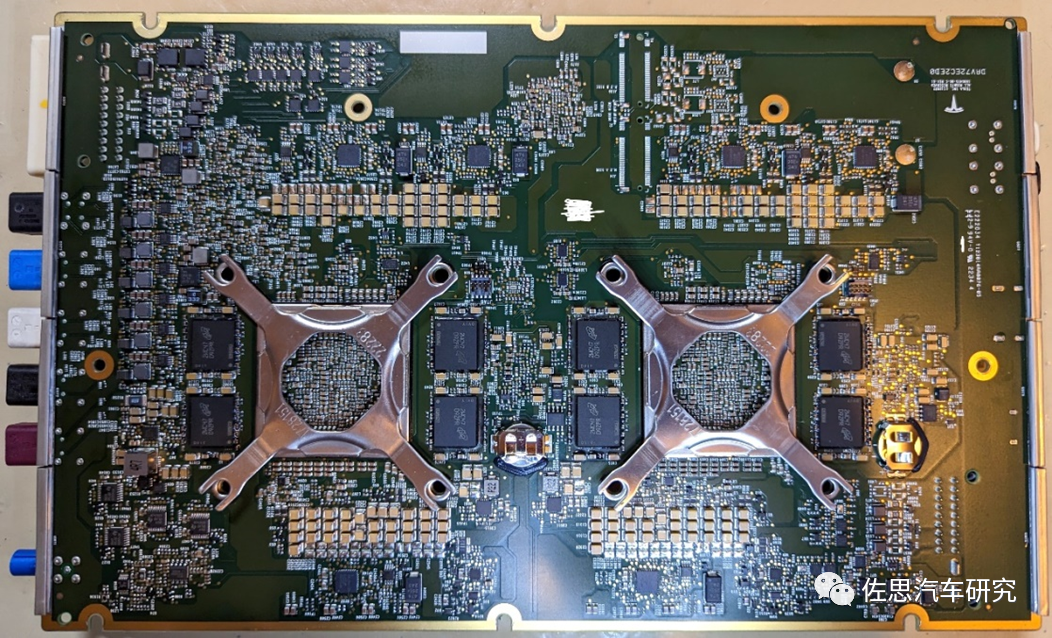

特斯拉HW4.0

图片来源:网络

特斯拉最新的自动驾驶大脑即HW4.0不惜血本用上了GDDR6,就是上图中的D9ZPR,正反两面各用了8颗,总计16颗,每颗容量2GB,在2021年初每片价格大约15美元。挖矿潮退潮,GDDR6价格持续暴跌,目前每片2GB价格大约7-8美元。实际HW4.0的座舱控制器里还有4颗GDDR6,每颗容量也是2GB,合计40GB即160美元以上。

大部分厂家都选择LPDDR4或LPDDR5,如英伟达的中配Orin开发盒子是4颗8GB即32GB的LPDDR5,只需要大约50美元,价格相差110美元。HW3.0使用的是8片2GB的LPDDR4,每片大约3.5美元,8片只有28美元。当然,最大赢家是美光,车载领域80%的DRAM市场由美光占据,以上提到的都由美光供应,这也是美国唯一存储器公司,是除英特尔外美国几乎唯一的硬科技公司(AMD的制造都是台积电完成的)

HBM结构图

图片来源:网络

HBM如上图,简单地说HBM就是将SDRAM用TSV工艺堆叠起来,就像盖楼一样,层和层之间会有金属层等间隔,同时通过TSV联通各个存储单元。TSV(硅通孔)是内存能够堆叠的关键,它能够在各个存储层之间以及层内构建出硅通孔的通路,存储单元的访问就通过这些通孔完成。在堆叠上,HBM2是8层,HBM3是12层,每多堆叠一层意味着良率就会下降一部分,因此成本越来越高。HBM4可能需要16层。

为最大限度发挥HBM的性能优势,HBM必须采用2.5D或3D封装,与逻辑部分的物理距离尽量地短,目前主流的2.5D封装只有台积电的CoWoS工艺,其次是英特尔的EMIB,亚马逊就全部使用英特尔的EMIB工艺,EMIB工艺性能略低于台积电的CoWoS工艺,但价格远低于台积电。

HBM增加的成本不仅仅是内存本身,还有台积电CoWoS工艺的成本。目前HBM3的采购价大约每GB为14美元,但由于CoWoS目前产能紧张,价格很高,实际每GB的HBM3增加成本大约20美元,业内推测英伟达H100的成本大约3300美元,售价在3万美元以上,毛利率90%,其中近一半的成本都来自HBM3。汽车行业所需内存容量不大,32GB足够,如果使用HBM2E的话,大概增加400-500美元成本。

系统的存储带宽不仅取决于存储器本身,更重要的是CPU的存储带宽与通道数,它决定了系统的最高存储带宽。每一种类型的存储器都需要与之对应的存储控制器和物理层,在设计芯片时就确定了只能用某一类型的存储芯片,目前除了特斯拉,所有的车载芯片最高只对应LPDDR5。汽车领域中CPU和AI运算是共享DRAM内存,因此需要兼顾CPU和AI的需求,CPU需要的是高速度,AI需要的是高吞吐量,二者是矛盾的,大部分都迁就CPU,更注重速度。

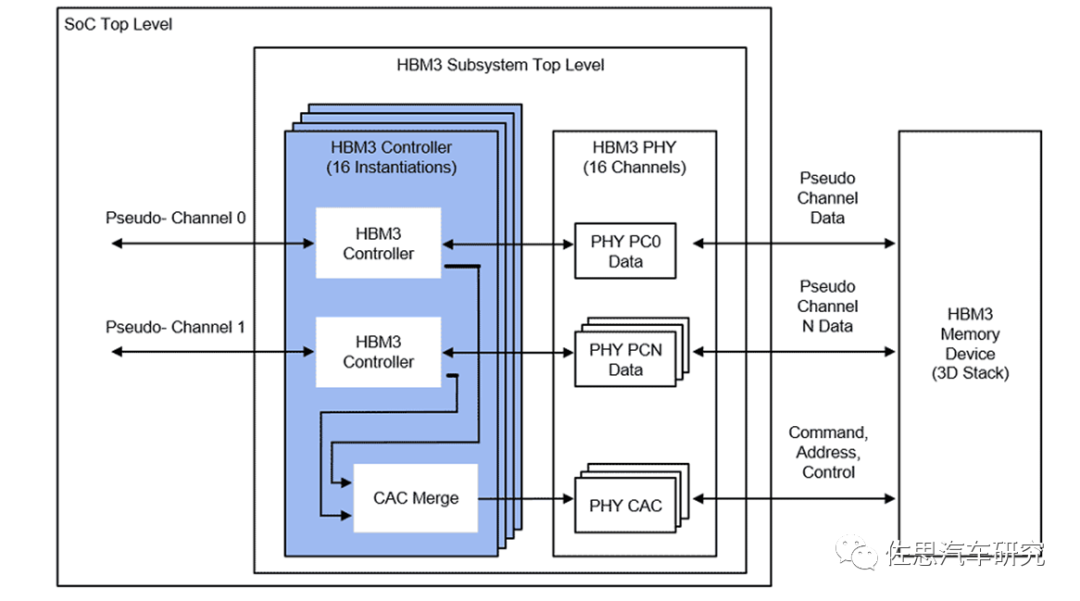

HBM3控制器框架图

图片来源:网络

同样是用HBM3,存储带宽依然可能差距很大,比如AMD的MI300X,采用了Chiplet设计,存储器通道最高可达8个,而英伟达是单光刻设计,最高通道仅有4个,虽然MI300X考虑成本,采用了SK Hynix的第一代HBM3存储器,这是SK Hynix的独特规格,每通道最高只有665GB/s,远低于英伟达H100的819GB/s,但MI300X是8通道,内存带宽就是665*8=5.32TB/s。

常见芯片存储带宽统计

(完整内容请参见《佐思汽车新四化每周观察》12月第1期)

目前车载芯片特斯拉二代FSD最高,最低估计有448GB/s,最高估计有1008GB/s。目前SK Hynix提供的HBM2E型号为H5WG6HMN6QX038R,最低带宽为460GBs,容量为16GB,双通道设计即可达920GB/s,最高估计可达1840GB/s,不过性价比与GDDR6还是差距较大。预计车载存储的下一波会是GDDR6,再下一波才有可能是HBM,特斯拉的HW 5.0或者说第三代FSD芯片可能会采用HBM存储。

审核编辑:黄飞

-

大模型时代的算力需求2024-08-20 0

-

【「大模型时代的基础架构」阅读体验】+ 未知领域的感受2024-10-08 0

-

【「大模型启示录」阅读体验】如何在客服领域应用大模型2024-12-17 0

-

【汽车电子工程师必备】汽车总线设计及测试宝典2012-08-18 0

-

未来将进入移动新能源时代2017-11-09 0

-

ADI倾力五大领域,力助汽车驶入智能时代2018-10-11 0

-

F-RAM存储技术是怎样进入汽车核心应用领域的?2021-05-13 0

-

手机制造企业为什么要进入汽车领域 进入汽车领域有必要吗2022-06-22 2591

-

ChatGPT带旺HBM存储2023-02-15 5093

-

华为发布大模型时代AI存储新品2023-07-14 798

-

魔方大模型在智能汽车领域的应用实践与探索2023-08-30 1511

-

SK海力士HBM3E正式量产,巩固AI存储领域的领先地位2024-03-19 1021

-

SK海力士HBM4E存储器提前一年量产2024-05-15 826

-

AI时代核心存力HBM(上)2024-11-16 581

-

芯片静电测试之HBM与CDM详解2024-12-16 441

全部0条评论

快来发表一下你的评论吧 !