AI智能体生态圈和软件栈

电子说

描述

原文链接:https://www.letta.com/blog/ai-agents-stack

一,理解AI智能体

尽管市面上有许多关于智能体堆栈和市场的分类,但我们认为这些分类并不总能准确反映开发者实际使用的工具和技术。随着内存、工具使用、安全执行和部署方面的进步,我们决定分享基于我们一年多的开源AI工作和7年以上的AI研究经验的“智能体堆栈”。

2024年末的AI智能体堆栈,被组织成三个关键层:

智能体托管/服务

智能体框架

LLM模型与存储

二,从LLM到LLM智能体

2022年和2023年见证了LLM框架和SDK的兴起,以及通过API消费LLM和自部署LLM推理的平台的建立。2024年,我们看到了对AI“智能体”的兴趣急剧转变,智能体通常指被赋予输出动作(工具调用)并在自治环境中运行的LLM。

三,智能体堆栈的独特之处

智能体比基本的LLM聊天机器人是一个更复杂的工程挑战,因为它们需要状态管理(保留消息/事件历史,存储长期记忆,执行多个LLM调用在智能体循环中)和工具执行(安全执行LLM输出的动作并返回结果)。

因此,AI智能体堆栈与标准的LLM堆栈看起来非常不同。让我们从模型服务层开始,分解今天的AI智能体堆栈:

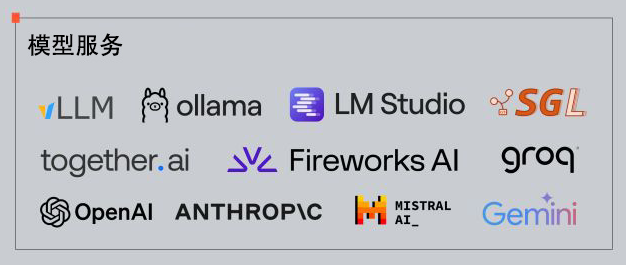

1,模型服务

LLM是AI智能体的核心,需要通过推理引擎提供服务,通常运行在付费API服务后面。OpenAI和Anthropic在封闭API模型推理提供商中领先,而Together.AI、Fireworks和Groq等提供开放权重模型服务。vLLM在本地模型推理提供商中领先。

2,存储

存储是智能体的基本构建块,智能体需要持久状态,如对话历史、记忆和外部数据源。向量数据库如Chroma、Weaviate等流行于存储智能体的“外部记忆”。Postgres通过pgvector扩展支持向量搜索。

3,工具和库

智能体与AI聊天机器人的主要区别在于智能体能够调用“工具”。LLM生成结构化输出指定要调用的函数和参数。智能体服务必须使用沙箱以确保安全执行。智能体通过OpenAI定义的JSON模式调用工具,这意味着智能体和工具可以跨不同框架兼容。

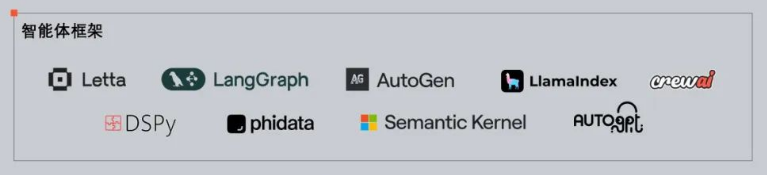

4,智能体框架

智能体框架协调LLM调用和管理智能体状态,不同框架在状态管理、上下文窗口结构、跨智能体通信和内存方法上有不同的设计。智能体框架的选择取决于应用程序的需求。

5,智能体托管和智能体服务

大多数智能体框架设计为智能体仅存在于编写的脚本或笔记本中。我们认为智能体的未来是作为服务部署到本地或云基础设施,通过REST API访问。部署智能体作为服务比部署LLM更复杂,涉及状态管理和安全工具执行。

四,总结

智能体堆栈仍处于早期阶段,我们期待看到生态系统的扩展和演变。有兴趣的读者可以查看Letta OSS项目和注册Letta Cloud的早期访问。

看了以上内容,你的看法是?欢迎评论区留言讨论!

审核编辑 黄宇

-

SINOCES搭建全球消费电子掘金生态圈2013-07-18 0

-

【eBox生态圈】资料、教程2015-12-14 0

-

ADI与合作伙伴共建智能汽车生态圈2019-07-25 0

-

ADI积极扩建本地智能汽车生态圈2020-08-17 0

-

CLAA物联网生态圈和LoRa行业现状分析2020-12-28 0

-

小米有大梦想,构筑智能家居生态圈2014-05-23 896

-

AI应用推动大数据融合创新生态圈建设2018-06-13 3799

-

日新月异的AI时代下,安防生态圈建设被提上了日程2018-08-29 461

-

ATH生态圈系统模式源码2018-10-12 441

-

国内首家AI作物诊断项目面世 积极布局农业互联网生态圈2018-12-05 808

-

首个全国范围AI竞赛,推进企业合作,共建AI生态圈”2019-04-01 3008

-

关于英飞凌汽车电子生态圈的分析介绍2019-09-25 3164

-

教你如何打造AliOS生态圈2021-05-19 2866

-

OpenHarmony Tech Day技术日 深开鸿打造OpenHarmony人才生态圈2022-04-25 829

-

智能汽车软件功能安全的“夹缝生长”2023-06-13 942

全部0条评论

快来发表一下你的评论吧 !