把人们的驾驶常识总结归纳为数学模型编入无人驾驶汽车内

电子说

描述

Mobileye 认为,人类驾驶员是一个很复杂,在计算机看来“非标准”的群体:有激进的司机,也有保守的司机,想准确预测个体司机的意图很难。人类在驾驶中无时无刻不在进行博弈,而无人车想要与人类驾驶员共存,就不得不参与这种博弈。Mobileye提出的RSS理论模型想要做到的事,就是把人们的驾驶常识总结归纳为数学模型,并且教会每一辆无人车。

机器人不得伤害人类,或坐视人类受到伤害;

除非违背第一法则,否则机器人必须服从人类命令;

除非违背第一或第二法则,否则机器人必须保护自己。

所有突破界限新技术的诞生,都不可避免地伴随着道德伦理和关于人类存亡的讨论。

过去是机器人,今天轮到无人车了。

至今我们已经对机器人做了足够多的讨论,业界也有像马斯克和扎克伯格这样的对人工智能坚持不同看法的大佬,至少当强人工智能到来之时,人类不会是全无准备的羔羊。

而比起机器人,无人车无疑是命途多舛的。从上路开始,不断发生的重大负面新闻就一直在刺激人们的神经,无人车就像个刚学会跑步,就不得不接受众人审判的孩子。

今年三月在美国亚利桑那州坦佩市,面对一名违反交规横穿马路的女性,Uber 公司旗下的无人车选择了不减速直接碾过;同月,特斯拉 Model X 在辅助自动驾驶 (Autopilot) 模式下撞上隔离带,致车主死亡;上周,其它驾驶员的错误导致一辆 Waymo 自动驾驶车卷入车祸。

这些事故的发生,究竟是谁的责任很重要,但在当下的舆论环境下没人关心。尽管经过近两个月的调查,警方认为安全员和违规过马路的行人亦负有责任,但 Uber 无人车这个“第一起自动驾驶汽车杀人事件”的帽子,一时半会儿肯定摘不掉了。前几天 Waymo 车祸发生时,很多人在了解现场情况之前,下意识地就觉得是无人车的错。

无人驾驶技术的成熟只是时间问题,然而想让公众信任无人车,和无人车分享道路,甚至是把生命安全交给无人车,仍然是个棘手的难题。无人车的每一次事故,哪怕只是被卷入车祸,都会引起公众的怀疑和恐慌。长此以往,这种不信任足以摧毁这个新兴的行业。

还好,已经有人在考虑这个问题,并且给出了一份很有说服力的答卷。

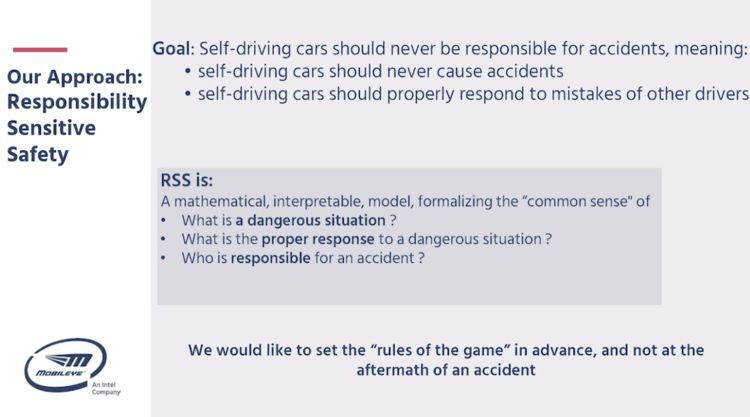

英特尔旗下,汽车图像技术老牌公司 Mobileye,发表了一篇名为《安全、可扩展自动驾驶汽车的正式模型》的论文。在这篇论文里,该公司提出了一个名叫RSS(Responsibility-Sensitive Safety)的理论模型。

这个理论主张在事故发生之前规避事故,而不是等事故发生后再进入复杂的定责程序。

英特尔和 Mobileye 希望,这个理论像自动驾驶界的“阿西莫夫机器人三定律”一样,成为让业界普遍接受、让公众感到放心的无人车守则。

Mobileye 认为,人类驾驶员是一个很复杂,在计算机看来“非标准”的群体:有激进的司机,也有保守的司机,想准确预测个体司机的意图很难。人类在驾驶中无时无刻不在进行博弈,而无人车想要与人类驾驶员共存,就不得不参与这种博弈。

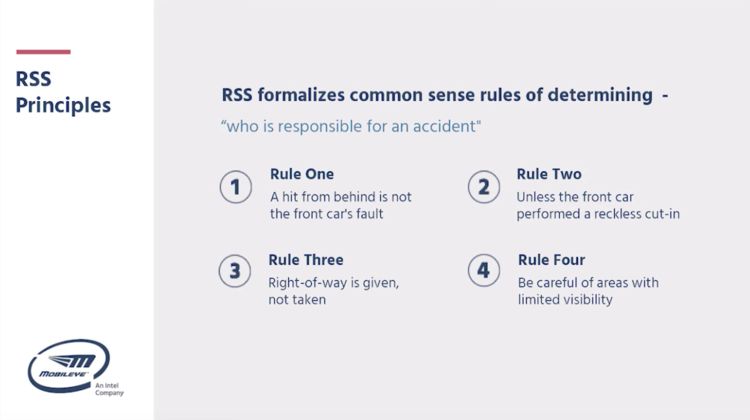

以汽车并道为例,在并道时发生刮蹭,前车会说后车进得太急,后车会说前车司机跑神反应太慢,到底谁说的是真谁说的是假,还得交警和保险公司一起来决定。无人车又没有嘴,最好的办法就是在保证绝对安全的前提下再行动。

Mobileye 航拍的真实路况,挤不进去的白车心里苦

在英特尔投资全球峰会上,Mobileye CTO 兼联合创始人阿姆农·沙书亚 (Amnon Shashua) 谈及车祸定责问题时表示:

在 RSS 的框架下,如果无人车出了事故,那一定是人的责任。

为了做到这点,Mobileye 也提出了无人车的两条定律:

第一,无人驾驶车永不主动造成事故;

第二,无人驾驶车对其他司机的不当行为有正确反应,不扩大事故。

这两条铁律应当如同不能伤害人类、不能坐视人类被伤害的机器人定律一样,高悬在每一辆无人车做出的每一个决策之上。

沙书亚指出,RSS 的数学模型可以解决三个问题:1,什么是危险的情况;2,什么是正确的反应;3,事故的责任方是谁。

首先,通过摄像头、雷达、和激光雷达的传感融合,无人车能同时检测周围车辆、行人以及可驾驶路径,同时计算距离,因此能更好地判断路况。

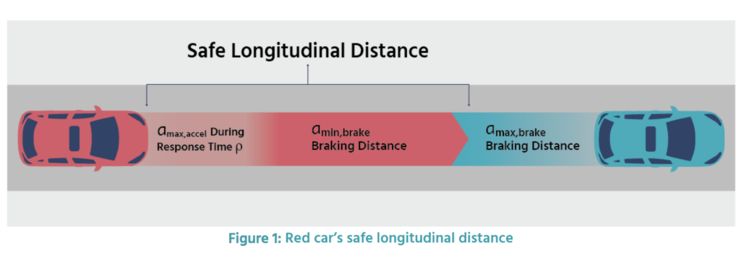

RSS 数学模型中计算的安全距离,只有满足安全距离的要求,无人车才会并线。

然后,在采取行动时,RSS 则会保证在拥有路权、前方和两侧都满足安全距离要求、且没有视觉死角时才变道、并线、转弯。

RSS 四原则

利用数据驱动的机器学习算法,Mobileye 已经在 RSS 模型下进行了 10 万次路测驾驶模拟实验,系统性能达到每秒 10hz 的频率响应,没有发生任何事故。

在提到 RSS 模型的必要性时,沙书亚表示,“技术的成熟只是第一步。RSS 做到的事,就是把人们的驾驶常识总结归纳为数学模型,并且教会每一辆无人车。”

然而,如果无人车过度敏感,则会走向另一个低效率的极端。乘客宛如一个被保护得很好但行驶缓慢、不断经历加速减速过程的鸡蛋,同样体验不佳。这个问题又要怎么解决?

沙书亚说,“在无人车产业中,没有大概能行这回事,为了保证用户和其他车辆的安全,无人车要做到的是一定能行。

统计学中有假阴性和假阳性的概念,用在今天讨论的话题上,就是‘该刹车没刹车’,和‘不该刹车但是刹车了’。

假阴性是很好测试的,因为该刹车的时候没刹车,车绝对要撞,只需要设置路障,统计无人车的通过率就可以了。而检测假阳性相对较难。你能想象你的无人车,路上遇见个矿泉水瓶都要抖三抖么?没人愿意坐这样的车。经过 RSS 系统的训练,英特尔已经收集了两亿公里的实际行驶数据,将假阳性出现概率降低到了万分之 2.5,也即每五万公里只出现一次。

“一旦 RSS 被无人车产业接受,事故定责将变得更容易。如果没有这个模型,无人车就没法真正上路。看看 Waymo 的事故录像,撞来的小车的确无处闪避,但 Waymo 还是承担了责难。因此我们急需一个模型来划分责任、定义危险行为,能被监管部门接受,能向公众明确解释事故原因,而不是呈现给大家一个似是而非的黑箱。”

如果将人工智能比做蒸汽,将无人车比做火车,毫无疑问,如今正在发生的是一场如蒸汽火车第一次开动一般翻天覆地的交通革命。

沙书亚说,“无人车替代其他汽车的过程是漫长的循序渐进的,在这个过程中必须优先考虑无人车与人类司机共存的情况。等到无人车达到了一定数量,我们或许可以让无人车之间实现沟通,但那就是另一个故事了。”

另一个故事里,塞车不存在了,红绿灯也消失了,保险公司失业了,人只要坐在后座,看无人车表演就够了。

-

无人驾驶导航平台2014-11-11 0

-

百度无人驾驶车北京完成路测2015-12-12 0

-

谷歌欲在英国首推无人驾驶汽车2015-12-14 0

-

【话题】无人驾驶汽车,真的要来了么?2016-06-24 0

-

无人驾驶电子与安全2017-02-22 0

-

2017全球无人驾驶汽车展2017-02-22 0

-

全球首款模块化无人驾驶汽车Edit:可定制想要风格2017-05-23 0

-

无人驾驶与自动驾驶的差别性2017-09-28 0

-

激光雷达-无人驾驶汽车的必争之地2017-10-20 0

-

无人驾驶汽车的关键技术是什么?2020-03-18 0

-

无人驾驶汽车将改变人们的生活、工作以及城市的建立和设计2020-05-13 0

-

无人驾驶分级及关键技术2021-01-21 0

-

无人驾驶汽车的工作原理是什么?2021-06-28 0

-

介绍无人驾驶硬件平台设计2021-09-09 0

-

无人驾驶硬件系统主要包括哪些2021-09-09 0

全部0条评论

快来发表一下你的评论吧 !