频繁出现的深度学习“寒冬论”,荣耀属于深度学习

电子说

描述

ACM刚刚公布2018年图灵奖获得者,深度学习三巨头:Yoshua Bengio、Geoffrey Hinton、Yann LeCun获奖,深度学习获得了最高荣誉。三巨头获奖的背后,是一段经历了寒冬的艰辛之路。

荣耀属于深度学习。

2018年图灵奖公布,深度学习三巨头:Yoshua Bengio、Geoffrey Hinton、Yann LeCun获奖,三人瓜分100万美元奖金。

Yann LeCun、Geoffrey Hinton、Yoshua Bengio

Yoshua Bengio(58岁)是蒙特利尔大学教授,也是魁北克人工智能研究所的科学主任;

Geoffrey Hinton(71岁)是谷歌副总裁和Engineering Fellow,Vector人工智能研究院首席科学顾问,多伦多大学名誉教授;

Yann LeCun(55岁)是纽约大学教授、Facebook副总裁兼首席AI科学家。

三位获奖者在业内被称为“当代人工智能教父”,开创了深度神经网络(deep neural network),而这项技术已经成为计算科学的关键部分,为深度学习算法的发展和应用奠定了基础。

去年,”深度学习寒冬论“频起,三位大神也在多个场合对”寒冬“做出了回应。实际上,三人对“寒冬”早有抗体,在上世纪八十年代,Geoffrey Hinton等人坐了数年的冷板凳,直到本世纪AI的再度爆发。

不仅如此,Geoffrey Hinton还提出新的神经网络模型Capsule Network(胶囊网络),试图找到解决深度学习缺陷的新方法,这位71岁的老人熬过最冷的AI冬天,并且认定下一个“冬天”不会到来。

挺过寒冬

Hinton早年的科研之路可谓坎坷至极。

他最开始读的是剑桥大学物理和化学专业,但只上了一个月就转到了建筑专业,结果只在建筑系待了一天就受不了,重新注册了物理和生理学,后来发现物理中的数学太难了,于是他又转向了哲学,花一年时间学了两年的课程。

虽然只有短短一年,但却是非常有用的一年,因为他对哲学产生了非常强的抗体:“我想知道大脑是如何工作的”。

为了弄明白大脑的工作原理,Hinton转而研究心理学,结果却发现“心理学家对此毫无头绪”。

1973年Hinton进入爱丁堡大学研究生院,师从Christopher Longuet-Higgins学习人工智能。但当时正值1970年代的人工智能寒冬出现,深度学习和AI都受到了学界轻视。

Christopher Longuet-Higgins

并且,Christopher是著名的理论化学家和认知科学家,桃李满天下,曾培养出诺贝尔奖获得者,但Hinton与导师的理念不同:导师坚持传统的逻辑人工智能理念,Hinton则坚信基于神经元理论的模拟神经元,坚信神经网络一定是未来的发展方向。

“我的毕业生涯充满了坎坷,每周我们都会有一场争吵。”Hinton后来回忆,他一直在和导师做“交易”:“让我再做六个月的神经网络,我会向你证明它们是有效的。”但在六个月结束的时候,Hinton又说:再给我六个月,之后又说,“再给我五年时间”。

进入八十年代,Hinton真的成功了。

1986年,Hinton等人完成著名的论文Experiments on Learning by Back Propagation,证明在神经网络中的反向传播可以提供“有趣的”分布表示,提出了影响后世人工智能的新方法。

不过,当时既没有足够的数据,也没有足够的算力,神经网络无法进行大规模训练,业界对Hinton的神经网络依旧不感兴趣。Hinton参加学术会议时,经常坐在房间的最角落里,也得不到当时学界大咖的重视。

深度学习三巨头的诞生

好在还有一批跟Hinton一样的“顽固派”。

Yann Lecun是Hinton的博士后学生,也是神经网络的坚定信仰者。1989年,Yann LeCun在贝尔实验室提供了第一次反向传播的实际演示。

1993年,Yann LeCun在电脑上展示识别手写字

他将卷积神经网络与反向传播相结合阅读“手写”数字,后来卷积神经网络大规模应用,并在20世纪90年代末期处理了美国10%到20%支票的识别。

Yann LeCun在贝尔实验室是组长,他的组员就包括今天或图灵奖的另一位大神Bengio。

Bengio虽然不是Hinton的直系弟子,但也是被认为是和Hinton、LeCun一起推动深度学习浪潮的三位旗手,他开创了神经网络的语言模型language model先河。

从左至右:LeCun、Hinton、Bengio、吴恩达

2012年,Geoffrey Hinton和他的两名学生发表论文,提出了深度卷积神经网络模型AlexNet,在当年的ImageNet大规模图像识别竞赛中获得冠军。后来Hinton加入谷歌大脑,AlexNet成为图像识别中最经典的模型之一,在产业界也得到普遍应用,直到深度学习全面爆发。

更值得纪念的是,2015年,Geoffrey Hinton、Yann LeCun、Yoshua Bengio这三位深度学习巨头曾在Nature上共同发表一篇名为《深度学习》的综述文章,讲述了深度学习为传统机器学习带来的变革。

不仅打脸知乎问题,深度学习还革新工业与学术界协作

早在2015年,知乎上就出现问题:Yann LeCun、Geoffrey Hinton或Yoshua Bengio能得图灵奖吗?

问题地址:

https://www.zhihu.com/question/33911668

当时不少网友认为他们三人虽然贡献很大,但是不能得图灵奖。于是今天纷纷跑到问题下面自行打脸。

京东集团副总裁、加拿大Simon Fraser大学计算科学学院教授、统计与精算系教授、加拿大一级研究讲座教授、ACM Fellow、IEEE Fellow、ACM SIGKDD Chair裴健教授告诉新智元,今年图灵奖颁发给Hinton、LeCun和Bengio三位深度学习的开创者、坚持者和布道者,众望所归。

“三四年前不少人就预测(或者说是期望)Hinton老先生和深度学习能获奖。深度学习给我们日常生活带来的好处,是史无前例的。因此,说Hinton的深度学习拿图灵奖之前别人大概都不太好意思拿这个奖,也许不算太过分。我相信,深度学习已经成为计算的一个基本元素。”

裴健说,这三位大神的故事和各种花边新闻已经广为流传了,无须赘述。有三点感想,值得自己学习,也和同行共勉:

首先,这三位长期聚精会神,荣辱不惊,是真正的学者。特别是Hinton老先生,他自八十年代初就开始对这个几度沉浮的领域作出了突出贡献 。三十多年他集中精力研究一个方向,不分心,不居功自傲,不因以往成就好为人师。这种严谨治学的精神非常值得我们后辈学习。我个人感觉,ACM在评大至图灵奖小至Fellow上学术质量至上,严谨严格。

其次,虽然三位都出身学术界,但为了推进深度学习的应用,他们不同程度上游走于工业界。他们给工业界带来的重要贡献不但是用深度学习方法解决了一批实际问题,更重要的是在工业研发上推广科学治学原则和方法。

这种真正在科学方法论上的产学研结合培养了一大批既具有扎实学术功底和研究方法又具有广阔的工业界视野和实际问题思维的新型年轻人才。可以这么说,深度学习的影响不但止在技术上,还包括对学术界和工业界协作方式以及未来人才培养模式的革新。(做一个广告:4月10日澳门召开的IEEE ICDE 2019大会上,我组织了一个panel,请到了著名的大学校长、杰出的工业界研发负责人和成功的新技术创业投资者专门讨论这个问题。敬请关注。)

最后,他们的获奖说明了一个鼓励持续性独立研究的环境非常重要。在深度学习不太受待见的漫长日子里,加拿大国家研究基金慷慨地支持了这几位为代表的一批深度神经网路研究者的持续深入研究,使得这个星星之火最终成就燎原之势。我本身在加拿大学习工作多年,非常喜欢那种平等平淡的研究环境,能使学者静心思考。尽管深度学习大热,加拿大学术界也是持比较理性的态度。Bengio这么大的名气,也是2017年才评上加拿大皇家院士的。

ACM主席Cherri M. Pancake说,人工智能的发展以及人们对它的兴趣,在很大程度上要归功于 Bengio、Bengio 和 LeCun 为之奠定基础的深度学习的最新进展。这些技术被数十亿人使用。任何口袋里有智能手机的人都能实实在在地体验到自然语言处理和计算机视觉方面的进步,这在10 年前是不可能的。除了我们每天使用的产品,深度学习的新进展也为医学、天文学、材料科学等领域的科学家们提供了强大的新工具”。

“深度神经网络对现代计算机科学的一些重大进步做出了贡献,帮助在计算机视觉、语音识别和自然语言理解等领域长期存在的问题上取得了实质性进展。”谷歌高级研究员、谷歌AI高级副总裁Jeff Dean表示:“这一进步的核心是今年的图灵奖获得者Yoshua Bengio、Geoffrey Hinton和Yann LeCun 在30多年前开发的基础技术。通过大幅提高计算机理解世界的能力,深度神经网络不仅改变了计算领域,而且几乎改变了科学和人类努力的每一个领域。”

频繁出现的深度学习“寒冬论”

从去年开始,关于深度学习“寒冬”、“至顶”的论调频繁出现,不少人认为深度学习似乎遇到了瓶颈,需要特别大、特别深的网络以及大量数据训练。

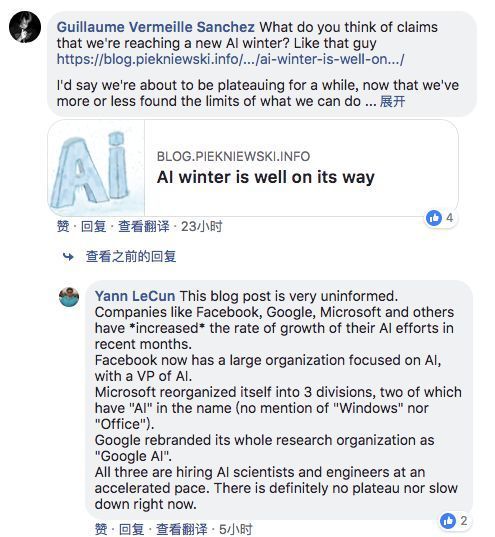

对此,几位获图灵奖的深度学习大神在不同场合回应过“寒冬论”。

LeCun:

LeCun曾直言深度学习寒冬论的作者缺乏常识,文章的观点非常无知(very uninformed)

Hinton:

Hinton认为,不会有人工智能的寒冬,因为AI已经在驱动着手机了。在过去的人工智能寒冬,AI并不是人们日常生活的一部分,但现在它已经是了。

更可贵的是,大神Hinton,一直奋斗在深度学习第一线,一方面推倒重建,一方面更好地理解深度学习。

2017年,Hinton跟他在谷歌大脑两个同事发表了《Dynamic Routing Between Capsules》,提出新的神经网络模型Capsule Network(胶囊网络),在特定任务上比传统的卷积神经网络取得了更好的效果。

Hinton认为,Capsule网络最终将超越视觉,推广到更广阔的应用场景,尽管现在很多人还存在质疑,但他确信现在就像5年前很多人对神经网络存疑一样。

“历史将会重现“。

全面认识深度学习三巨头

以下是ACM对三位大神的官方介绍,读者若已熟悉,可跳过本部分。

Geoffrey Hinton

Geoffrey Hinton是谷歌副总裁兼Engineering Fellow,向量研究所首席科学顾问、多伦多大学名誉教授。Hinton在剑桥大学获得实验心理学学士学位,在爱丁堡大学获得人工智能博士学位。他是CIFAR的神经计算和自适应感知(后来的“机器和大脑学习”)项目的创始主任。

Hinton曾获加拿大最高荣誉勋章,英国皇家学会会员,美国国家工程院外籍院士,国际人工智能联合会议(IJCAI)卓越研究奖,NSERC Herzberg金牌奖,及IEEE James Clerk Maxwell金牌。他还被“连线”杂志选为“2016年度最具影响力100人”之一,并被彭博社选为2017年“改变全球商业格局的50人”之一。

Yann LeCun

Yann LeCun是纽约大学Courant数学科学研究所的Silver教授,Facebook的副总裁兼首席AI科学家。他在英国电子技术与电子学院(ESIEE)获得高等英语学士学位,在玛丽·居里·皮埃尔大学获计算机科学博士学位。

LeCun是美国国家工程院院士,来自墨西哥IPN和洛桑联邦理工学院(EPFL)的荣誉博士,宾夕法尼亚大学Pender奖得主,埃因霍温技术大学和飞利浦实验室Holst奖章获得者,诺基亚-贝尔实验室Shannon Luminary奖、IEEE PAMI杰出研究员奖、以及IEEE神经网络先锋奖。

他被《连线》杂志选为“2016最具影响力人物100人之一”以及“25位创造商业未来的天才”之一。LeCun是纽约大学数据科学中心的创始主任,也是CIFAR学习机器和脑力项目的负责人(与Yoshua Bengio共同担任)。 此外,LeCun还是人工智能合作伙伴关系委员会的联合创始人和前成员之一,该机构是研究AI的社会后果的企业和非营利组织的联合体。

Yoshua Bengio

Yoshua Bengio是蒙特利尔大学的教授、魁北克人工智能研究所和IVADO(数据实验研究所)的科学总监。他是CIFAR机器和脑力学习项目的联合主任(与Yann LeCun共同担任)。 Bengio拥有麦吉尔大学电子工程学士学位,计算机科学硕士和博士学位。

Bengio曾获加拿大勋章,加拿大皇家学会会员和Marie-Victorin奖。他创建魁北克人工智能研究所(Mila)和并担任该所科学主任也被认为是对AI领域的重大贡献。 Mila是一家独立的非营利组织,目前拥有300名研究人员和35名教职员工,目前是世界上最大的深度学习研究学术中心,并使蒙特利尔成为一个充满活力的AI生态系统,全球多家大公司和AI创业公司均在此设立研究实验室。

三位大神的成就

最后,送上本次获图灵奖的三位大神的主要技术成就,这些成就对其后的深度学习研究产生了巨大的影响,值得后人铭记。

Geoffrey Hinton

反向传播:

1986年,Hinton与David Rumelhart和Ronald Williams共同撰写了“Learning Internal Representations by Error Propagation”论文,Hinton等人在文中证明了反向传播算法可以让神经网络发现自身的数据内部表示,这一发现让神经网络有可能解决以前被认为不可解决的问题。反向传播算法已经成为如今大多数神经网络的标准。

玻尔兹曼机:

1983年,Hinton与Terrence Sejnowski一起共同发明了玻尔兹曼机,这是第一个能够学习不属于输入或输出的神经元内部表示的神经网络之一。

对卷积神经网络的改进:

2012年,Hinton与他的学生Alex Krizhevsky和Ilya Sutskever一起使用整流线性神经元和退出正则化改进了卷积神经网络。在著名的ImageNet图像识别大赛中,Hinton和他的学生几乎将对象识别的错误率降低了一半,可以说重塑了计算机视觉领域。

Yoshua Bengio

序列的概率模型:

20世纪90年代,Bengio将神经网络与序列的概率模型(如隐马尔可夫模型)结合起来。这些思想被纳入AT&T / NCR用于读取手写支票的系统中,成为20世纪90年代神经网络研究的巅峰之作,目前的深度学习语音识别系统正是这些概念的扩展。

高维词汇嵌入和注意力机制:

2000年,Bengio撰写了具有里程碑意义的论文“A Neural Probabilistic Language Model”,此文引入了高维词嵌入作为词义表示。Bengio的这个思想对日后的自然语言处理任务产生了巨大而深远的影响,其中包括语言翻译、问答和视觉问答系统开发等。Bengio的团队还引入了“注意力机制”,导致了机器翻译研究的突破,并成为深度学习的顺序处理的关键组成部分。

生成对抗网络(GAN):

自2010年以来,Bengio与Ian Goodfellow共同开发的生成对抗网络(GAN)引发了一场计算机视觉和计算机图形学的革命。GAN的一个引人注目应用是,计算机实际上能够生成原始图像,这种创造力往往被认为是机器具备人类智能的标志。

Yann LeCun

卷积神经网络:

20世纪80年代,LeCun开发了卷积神经网络,成为神经网络领域的基本模型。在20世纪80年代后期,LeCun在多伦多大学和贝尔实验室工作期间,首次在手写数字图像上成功了训练卷积神经网络系统。如今,卷积神经网络是计算机视觉、语音识别,语音合成、图像合成和自然语言处理领域的行业标准。已被用于自动驾驶、医学成像分析、语音助手和信息过滤等多个领域。

对反向传播算法的改进:

LeCun提出了反向传播算法的早期版本(backprop),并根据变分原理对其进行了简洁的推导。他表述了缩短学习时间的两种简单方法,从而加快了反向传播算法的速度。

拓宽神经网络的研究领域:

LeCun还拓宽了神经网络的研究领域,将神经网络作为一种计算模型应用于更广泛的任务上。他在早期研究中引入的许多思想和理念,现在已成为AI领域的基础概念。例如,在图片识别领域,他研究了如何让神经网络学习层次特征,这一方法现在已经用于很多日常的识别任务。他们还提出了可以操作结构数据(例如图数据)的深度学习架构。(转自新智元)

-

FPGA做深度学习能走多远?2024-09-27 0

-

Nanopi深度学习之路(1)深度学习框架分析2018-06-04 0

-

深度学习存在哪些问题?2021-10-14 0

-

深度学习模型是如何创建的?2021-10-27 0

-

什么是深度学习?使用FPGA进行深度学习的好处?2023-02-17 0

-

深度学习和机器学习深度的不同之处 浅谈深度学习的训练和调参2018-05-02 4331

-

深度学习是什么?了解深度学习难吗?让你快速了解深度学习的视频讲解2018-08-23 1135

-

深度学习的冬天什么时候到来?2019-07-12 3629

-

AI寒冬将至?深度学习的“新江湖”2019-09-20 2525

-

探讨机器学习与深度学习基本概念与运算过程2020-12-18 4301

-

什么是深度学习算法?深度学习算法的应用2023-08-17 2150

-

深度学习框架是什么?深度学习框架有哪些?2023-08-17 2740

-

深度学习框架和深度学习算法教程2023-08-17 1081

-

机器学习和深度学习的区别2023-08-17 4232

-

深度学习的由来 深度学习的经典算法有哪些2023-10-09 540

全部0条评论

快来发表一下你的评论吧 !