高效大模型的推理综述

什么是RAG,RAG学习和实践经验

MOE与MOT:提升LLM效能的关键策略比较

基于双级优化(BLO)的消除过拟合的微调方法

自然语言常用的自回归解码方法

斯坦福继Flash Attention V1和V2又推出Flash Decoding

大模型微调开源项目全流程

聊一聊Transformer中的FFN

LLM中的大规模激活

利用知识图谱与Llama-Index技术构建大模型驱动的RAG系统(下)

利用知识图谱与Llama-Index技术构建大模型驱动的RAG系统(上)

LLaMA 2是什么?LLaMA 2背后的研究工作

大模型系列:Flash Attention V2整体运作流程

开发RAG管道过程中的12个痛点

聊聊小公司如何做大模型

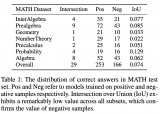

小红书搜索团队研究新框架:负样本在大模型蒸馏中的重要性

LLM推理加速新范式!推测解码(Speculative Decoding)最新综述

大模型微调实践心得与认知深化

大语言模型事实性幻象的实验性分析

深入了解RAG技术