借助人工智能,存储器比重将进一步增加

存储技术

609人已加入

描述

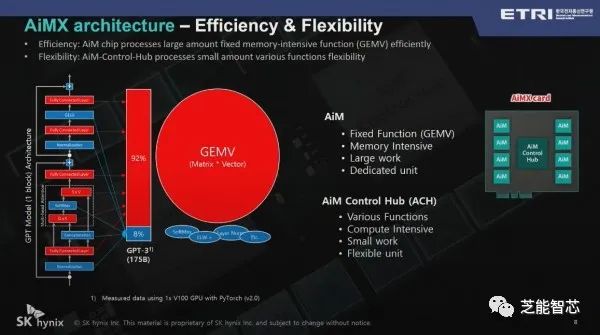

SK海力士预测在人工智能(AI)领域,存储器解决方案的比重将进一步增加,可以通过类似AiMX的解决方案部分替代图形处理单元(GPU)。在首尔江南区科技会议中心举行的“ETRI Conference 2023”上,SK海力士副社长表示,对于像BERT这样的模型,内存密集型功能仅占约5%,而在GPT2中,内存功能约占45%。在175B GPT3中,内存密集型功能已经达到92%。

内存密集型函数是GEMV,即矩阵和向量相乘的运算,是大型语言模型(LLM)的核心。“现在LLM的GEMV内存密集比例已达到92%”,并解释说,“92%是通过Accelerator in Memory(AiM)处理的,其余8%是通过AiM Control处理的Hub。SK海力士计划将AiM控制器改为AiMX专用SoC,而不是FPGA。

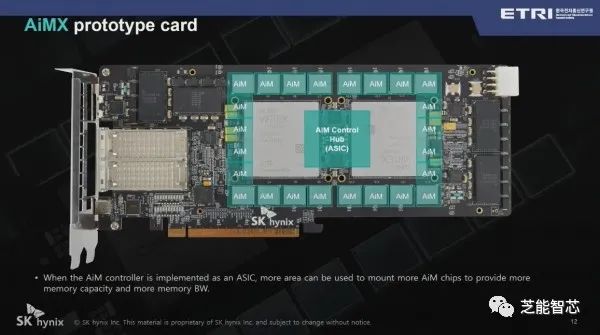

AiMX是SK海力士去年发布的基于内存的加速器,专为内存密集型函数计算进行优化,配备有16个1GB GDDR6-AiM和2个可编程半导体(FPGA)。“设计AiM控制中枢的成本太高,首先使用FPGA创建了一个加速器。当创建自己的片上系统时,将添加更多的GDDR6-AiM,以制造64GB或更大的产品。”

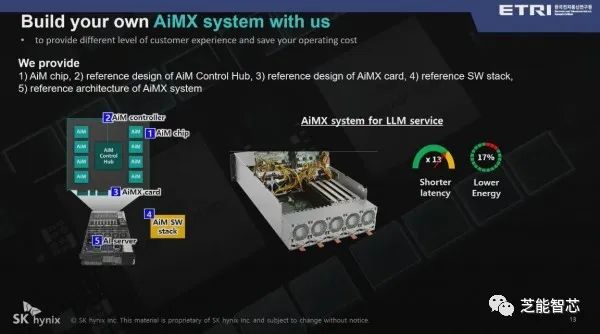

在LLM中,AiMX的延迟比GPU快13倍,功耗降低17%,与GPU相比,LLM具有更优越的性能。“主要供应AiM芯片并提供参考设计来帮助超大规模客户,”并表示SK海力士将支持创建加速器系统。由于公司最大的客户之一是GPU公司,因此在推广AiMX时需要谨慎,以确保其利益与客户的利益部分重叠。

审核编辑:黄飞

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片2024-05-13 0

-

了解人工智能,30份书单不容错过(附电子版PDF下载)2017-11-02 0

-

人工智能的影响超乎你想象2018-06-22 0

-

SOP位移传感器防水功能将进一步提高2019-08-20 0

-

人工智能能否在2018年再进一步 是否走出实验室2018-02-26 1700

-

美国制裁中兴后,中国对芯片、人工智能、5G的投入力度将进一步加强2018-04-19 10299

-

福建力推人工智能的规定制定及实施 进一步提高人工智能行业的发展2019-02-04 820

-

最高人民法院: 进一步以人工智能引领智慧法院建设2019-03-20 4409

-

随着互联网的进一步普及 人工智能发展正在加速崛起2019-05-07 1760

-

借助AI技术进一步改善视频营销2020-07-07 1889

-

"新基建”为智能网联汽车进一步发展提供了基础端的支撑2020-07-14 1250

-

人工智能进一步彰显“头雁效应”,引领科技革命2020-07-21 3167

-

天津市进一步支持发展智能制造的政策措施2020-10-12 3412

-

未来5年,人工智能与机器人将进一步扩大到各个就业岗位2020-10-23 2651

-

iOS 16为地图app进一步增加新细节2022-06-07 1348

全部0条评论

快来发表一下你的评论吧 !