数据中心内部和之间的远程数据移动如何避免HPC数据流量阻塞

电子说

描述

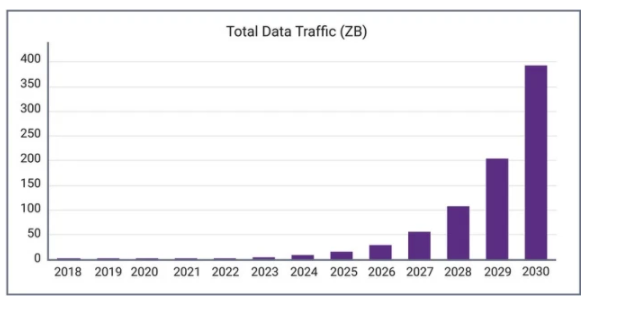

流媒体,监视和监视数据,连接的传感器,社交媒体,在线协作,远程学习,增强和虚拟现实,在线游戏……在线应用的无休止清单导致在线数据激增。在接下来的10年中,预计年度数据流量将增长400倍以上(图1)。数据流量的这种快速增长将需要显着提高数据接口IP的速度和延迟,尤其是在云基础架构中。本文研究了有助于加快和管理数据中心之内和之间,服务器内以及片上系统(SoC)包内的数据移动的技术发展。

图1:到2030年的总数据流量预测。资料来源:“人工智能对电子和半导体行业的影响”,IBS,2020年4月。

数据中心内部和之间的远程数据移动

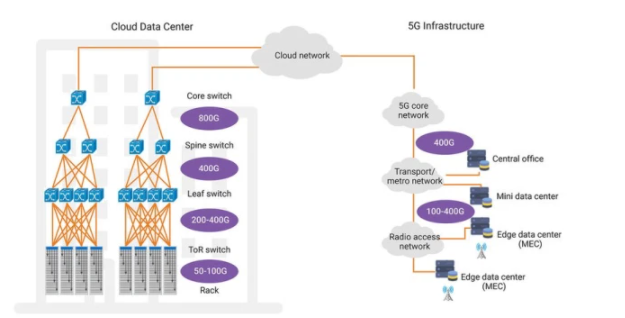

当今大多数大型数据中心都使用100Gbps以太网基础结构来长距离移动数据(例如,在机架和数据中心之间)。远程基础设施通常依赖于25个或28 Gbps NRZ SerDes电连接的4个通道。但是,随着数据量的增长,需要更高速度的基础架构来维持数据移动。使用支持PAM-4编码的56 Gbps和112 Gbps SerDes IP,可以在当前部署的超大规模数据中心实现400Gbps以太网连接,并在将来达到800Gbps的速度(图2)。领先的以太网交换机供应商已经在开发基于112G SerDes IP的800Gbps交换机,并计划在未来几年内推出1.6Tbps以太网(使用更快的下一代SerDes),以满足不断增长的数据量的需求。

机架内服务器之间的数据通信由机架顶(ToR)交换机和每台服务器内的网络接口卡(NIC)进行管理。在过去的几年中,此级别的云数据中心中最常见的接口速度为25Gbps。但是,随着基础架构速度增加到400Gbps,机架内的以太网速度也增加到100Gbps。

随着数据速率的提高,接口功率(通常以皮焦耳/位为单位)和面积变得越来越重要。物理接口(PHY)IP可以最大限度地减少能源消耗,同时在所需的距离范围内可靠地传输数据,具有明显的优势,可以最大程度地降低基础架构电源和冷却能力的成本。硅面积高效的PHY解决方案将SoC成本降至最低,从而提高了SoC供应商的盈利能力。

图2:超大规模数据中心基础架构正在过渡到400 + GbE。

服务器内的数据移动

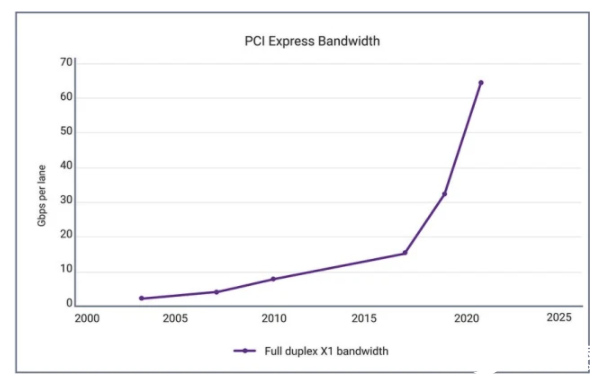

一旦所有这些数据到达服务器,就需要高速接口以将其有效地在服务器内的设备之间移动。例如,当数据以100Gbps的速度到达NIC时,必须迅速将其移至存储,系统内存,或者也许移至图形或AI加速器进行处理。这是PCI Express(PCIe),Compute Express Link(CXL)和类似协议的领域。为了应对流量的快速增长,PCI-SIG在2019年发布了PCIe 5.0,与上一代产品相比带宽增加了一倍,并计划在2021年发布PCIe 6.0,这将使PCIe数据速率再次翻倍至64 GT / s (对于x16卡,最高可达128GB / s)(图3)。

图3:每个通道的PCI Express带宽演进。资料来源: PCWorld。

由计算系统生成和处理的数据(尤其是非结构化数据)的数量最近和持续增长,催生了新的体系结构,通常采用加速器来促进数据处理。将数据从一个处理器域复制到另一个处理器域是一个资源密集型过程,可能会增加数据处理的延迟。高速缓存一致性解决方案允许处理器和加速器共享内存,而无需将数据从一个存储空间复制到另一个存储空间,既节省了存储资源,又节省了复制数据所需的时间。

CXL是一种缓存一致性协议,它利用PCIe的数据速率和物理层来使CPU和加速器能够访问彼此的内存。当多个设备需要访问单个数据集时,集成CXL协议有效地减少了非一致性协议必须出现的数据副本的数量,从而减少了系统内所需的传输次数。减少数据副本的数量有助于减少系统中已经大量订阅的内存和IO接口的负载。

与其他外围互连相比,CXL面向高性能计算工作负载,可显着减少延迟。由于cxl.cache和cxl.mem事务的延迟仅为50-80ns,因此CXL延迟仅是PCIe延迟的一小部分。此外,CXL通过使用资源共享来提高性能并降低复杂性,这也可以降低总体系统成本。

SOC中的USR / XSR数据移动

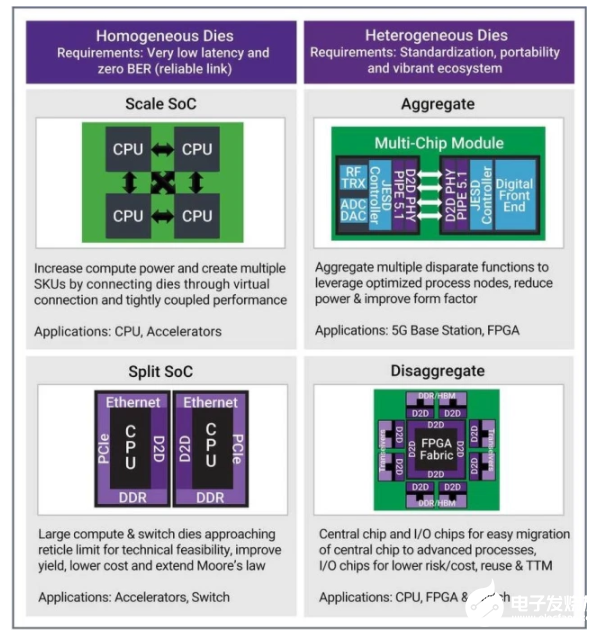

许多现代服务器SoC在单个封装中利用多个管芯,以在设计和制造约束下提供所需的性能。结果,需要高速管芯到管芯(D2D)通信,以在芯片内的管芯之间传递大型数据集。超短距离/超短距离(USR / XSR)SerDes使这一切成为可能,当前使用112Gbps SerDes的设计以及未来几年内可能会出现更高的速度。

使用D2D接口技术的多芯片模块可解决多种用例。所有D2D用例都减少了开发时间以及开发和制造成本。有些使用多个异类芯片或“小芯片”,它们利用可重复使用的功能组件,每个组件均使用针对其特定功能最佳的制造技术来构建。其他用例则通过创建大型高性能SoC来强调灵活性,该SoC使用较小的同类构建模块来提高产量和可扩展性。

图4:管芯到管芯互连的用例示例。

概要

云数据的快速增长推动了对更快,更高效的接口的需求,这些接口要求将云基础架构中的数据从网络和系统向下移动到芯片级数据通信。新的和正在开发的接口技术,包括400Gbps和更快的以太网,PCIe 6.0和CXL外围互连技术,以及用于管芯对管芯通信的新型高速SerDes,可实现支持不断发展的云数据需求所需的基础架构增强功能。

Synopsys的DesignWare®高速SerDes和以太网IP支持下一代数据中心网络解决方案。90%的领先半导体公司都使用DesignWare PCIe IP,它是DesignWare CXL IP的稳定可靠的基础。DesignWare 112G USR / XSR SerDes IP为多管芯SoC提供了一种低成本,高能效的管芯到管芯接口。Synopsys提供了经过硅验证的DesignWare接口IP以及开发用于满足当今和未来云基础设施不断发展的数据移动需求的高速,低功耗,高度可靠的SoC所必需的设计和验证工具的完整产品组合。

编辑:hfy

-

数据中心子系统的组成2011-11-11 0

-

数据中心布线五大注意要点2016-07-21 0

-

未来数据中心与光模块发展假设2020-08-07 0

-

数据中心布线之有源光缆2020-08-22 0

-

大数据和物联网是如何影响数据中心的?2021-05-21 0

-

数据中心太耗电怎么办2021-06-30 0

-

数据中心是什么2021-07-12 0

-

如何去提高数据中心的运营效率呢2021-09-09 0

-

什么是数据中心2021-09-15 0

-

数据中心网络三层拓扑结构的详述2017-10-18 3218

-

数据中心网络中的流量均衡2018-01-04 1126

-

边缘计算与多租户数据中心的相遇2019-11-12 3714

-

利用高速接口IP避免云数据流量拥堵2022-05-17 11244

-

浅谈:RDMA能给数据中心带来什么?2022-11-29 1113

-

传统数据中心架构和叶脊架构网络解决方案2024-03-21 1170

全部0条评论

快来发表一下你的评论吧 !