机器学习算法之基于黑盒语音识别的目标对抗样本

人工智能

描述

谷歌大脑最近研究表明,任何机器学习分类器都可能被欺骗,给出不正确的预测。在自动语音识别(ASR)系统中,深度循环网络已经取得了一定的成功,但是许多人已经证明,小的对抗干扰就可以欺骗深层神经网络。而目前关于欺骗 ASR 系统的工作主要集中在白盒攻击上,Alzantot 等人证明利用遗传算法的黑盒攻击是可行的。

而在接下来为大家介绍的这篇加州大学伯克利分校机器学习团队的论文中,引入了一个新的黑盒攻击领域,特别是在深层非线性的 ASR 系统中可以输出任意长度的转换。作者提出了一种将遗传算法和梯度估计结合的黑盒攻击方法,使之可以产生比单独算法更好的对抗样本。

在研究中,通过改进遗传算法从而应用于短语和句子中;将噪声限制在高频域上可以提高样本的相似度;而当对抗样本已经接近目标时,梯度估计会比遗传算法进行更有效的权衡,为未来的研究打开了新的大门。

以下为论文摘编:

对抗性攻击介绍

因为神经网络具有的强表达能力,使得它们能够很好地适应于各种机器学习任务,但在超过多个网络架构和数据集上,它们容易受到敌对攻击的影响。这些攻击通过对原始输入增加小的扰动就会使网络对输入产生错误的分类,而人类的判断却不会受到这些扰动的影响。

到目前为止,相比其他领域,如语音系统领域,为图像输入生成对抗样本的工作已经做了很多。而从个性化语音助手,如亚马逊的 Alexa 和苹果公司的 Siri ,到车载的语音指挥技术,这类系统面临的一个主要挑战是正确判断用户正在说什么和正确解释这些话的意图,深度学习帮助这些系统更好的理解用户,然而存在一个潜在的问题是针对系统进行目标对抗攻击。

在自动语音识别(ASR)系统中,深度循环网络在语音转录的应用已经取得了令人印象深刻的进步。许多人已经证明,小的对抗干扰就可以欺骗深层神经网络,使其错误地预测一个特定目标。目前关于欺骗 ASR 系统的工作主要集中在白盒攻击上,在这种攻击中模型架构和参数是已知的。

对抗性攻击(Adversarial Attacks):机器学习算法的输入形式为数值型向量,通过设计一种特别的输入以使模型输出错误的结果,这被称为对抗性攻击。根据攻击者对网络的了解信息,有不同的执行敌对攻击的方法:

白盒攻击:对模型和训练集完全了解;如果给定一个网络的参数,白盒攻击是最成功的,例如 Fast Grandient Sign Method 和 DeepFool;

黑盒攻击:对模型不了解,对训练集不了解或了解很少;然而,攻击者能够访问网络的所有参数,这在实践中是不现实的。在黑盒设置中,当攻击者只能访问网络的逻辑或输出时,要始终如一地创建成功的敌对攻击就很难了。在某些特殊黑盒设置中,如果攻击者创建了一个模型,这个模型是目标模型的一个近似或逼近模型,就可以重用白盒攻击方法。即使攻击可以转移,在某些领域的网络中也需要更多的技术来解决这个任务。

攻击策略:

基于梯度的方法:FGSM 快速梯度法;

基于优化的方法:使用精心设计的原始输入来生成对抗样本;

以往的研究

在先前的研究工作中,Cisse 等人开发了一个通用攻击框架,用于在包括图像和音频在内的各种模型中工作。与图像相比,音频为模型了提供了一个更大的挑战。虽然卷积神经网络可以直接作用于图像的像素值,但 ASR 系统 通常需要对输入音频进行大量预处理。

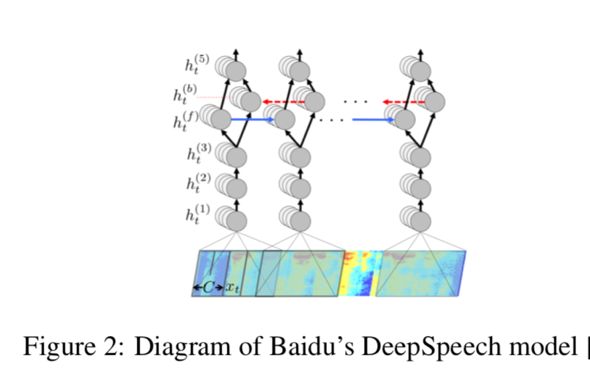

最常见的是梅尔-频率转换(MFC),本质上是采样音频文件的傅里叶变换,将音频转换成一个显示频率随时间变化的 spectogram,如下图中的DeepSpeech 模型,使用 spectogram 作为初始输入。当 Cisse 等人将他们的方法应用到音频样本时,他们遇到了通过了 MFC 转换层进行反向传播的路障。Carlini 和 Wagner 克服了这一挑战,开发了一种通过 MFC 层传递渐变的方法。

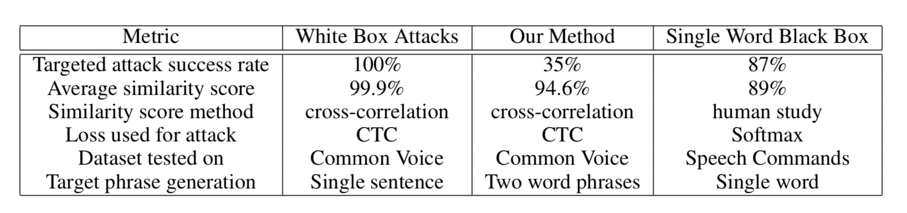

他们将方法应用到 Mozilla DeepSpeech 模型中(该模型是一个复杂、反复、字符级的网络,解码每秒 50 个字符的翻译)。他们取得了令人印象深刻的结果,生成超过 99.9% 的样本,类似于目标攻击的 100%,虽然这次攻击的成功为白盒攻击打开了新大门,但在现实生活中,对手通常不知道模型架构或参数。Alzantot 等人证明,针对 ASR 系统的目标攻击是可能的,利用遗传算法的方法,能够迭代地将噪音应用到音频样本中,这次攻击是在语音命令分类模型上进行的,属于轻量级的卷积模型,用于对 50 个不同的单词短语进行分类。

本文研究

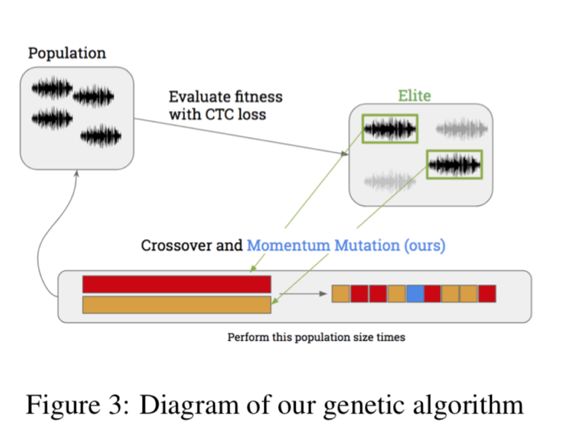

本文采用一种黑盒攻击,并结合了遗传算法与梯度估计的方法创建有针对性的对抗音频来实现欺骗 ASR 系统。第一阶段攻击是由遗传算法进行的,这是一种无需计算梯度的优化方法。对候选样本总体进行迭代,直到一个合适的样本产生。为了限制过度的突变和多余的噪声,我们用动量突变更新改进标准遗传算法。

攻击的第二阶段使用了梯度估计,因为单个音频点的梯度是估计的,因此当敌对样本接近目标时,允许设置更精细的噪声。这两中方法的组合提供了在3000 次迭代之后实现了 94.6% 的音频文件的相似性,89.25% 目标攻击相似性。在更复杂的深度语音系统上困难在于试图将黑盒优化应用到一个深度分层、高度非线性的解码器模型中。尽管如此,两种不同方法和动量突变的结合为这项任务带来了新的成功。

数据与方法

数据集:攻击的数据集从 Common Voice 测试集中获取前 100 个音频样本。对于每一个,随机生成一个 2 字的目标短语并应用我们的黑盒方法构建第一个对抗样本,每个数据集中的样例是一个 .wav 文件,可以很容易地反序列化成 numpy 数组,从而我们的算法直接作用于 numpy 数组避免了处理问题的难度。

受害者模型:我们攻击的模型是在 Mozilla 上开源,Tensorflow 中实现的百度深度语音模型。尽管我们可以使用完整的模型,但是我们仍将其视为黑盒攻击,只访问模型的输出逻辑。在执行 MFC 转换后,该模型由 3 层卷积组成,后面一个双向 LSTM,最后是一个全连接层。

遗传算法:如前所述,Alzantot 等人用标准的遗传算法演示了黑盒对抗攻击在语音到文本系统上的成功。带有 CTC 损失的遗传算法对于这种性质的问题很有效,因为它完全独立于模型的梯度。

梯度估计:当目标空间很大时,遗传算法可以很好的工作,而相对较多的突变方向可能是有益的,这些算法的优势在于能够有效地搜索大量空间。然而,当解码的距离和目标解码低于某个阈值时,需要切换到第二阶段,这时候梯度评估技术更有效,对抗样本已经接近目标,梯度估计会为更有信息的干扰做出权衡。梯度评估技术来源于 Nitin Bhagoji 在 2017 年的一篇研究图像领域黑盒攻击的论文。

结果与结论

评价标准:采用了两种主要方式评估算法性能;一是精确敌对音频样本被解码到所需目标短语的准确性;为此,我们使用 Levenshtein 距离或最小字符编辑距离。二是确定原始音频样本和敌对音频样本之间的相似性。

实验结果

在我们运行算法的音频样本中,在使用 Levenshtein 距离的最终解码短语和目标之间取得了 89.25% 的相似性;最终敌对样本和原始样本相关性为 94.6%。在 3000 次迭代后,平均最终 Levenshtein 距离是 2.3,35% 的敌对样本在不到 3000 次迭代情况下完成了精准解码,22% 的敌对样本在不到 1000 迭代时间内完成了精准解码。

本文提出的算法性能与表中数据结果有所不同,在几个迭代中运行算法可以产生更高的成功率,事实上,在成功率和相似率之间很明显存在着权衡,这样就可以通过调整阈值来满足攻击者的不同需要。

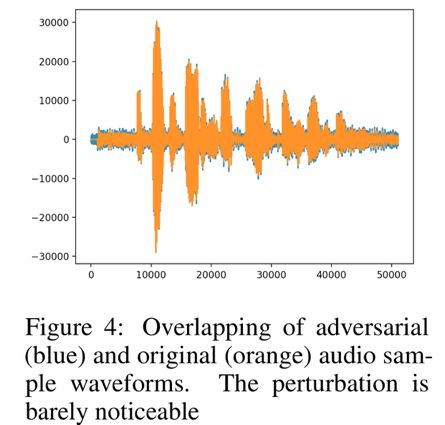

对比白盒攻击、黑盒攻击单个单词(分类)、以及我们所提出的方法:通过两种波形的重叠,可以看出原始音频样本与对抗样本之间的相似性,如下图显示出来的,35% 的攻击是成功的强调了黑盒的事实,对抗攻击的除了确定性同时也是非常有效的。

实验结论

我们在结合遗传算法和梯度估计的过程中实现了黑盒对抗,它能产生比每个算法单独产生的更好的样本。

从最初使用遗传算法使大多数音频样本的转录近乎完美,同时还保持高度的相似性。虽然这很大程度上还是一种概念性的验证,通过本文的研究展示了使用直接方法的黑盒模型可以实现针对性对抗攻击。

此外,加入动量突变和在高频中加入噪声,提高了我们的方法的有效性,强调了结合遗传算法和梯度估计的优点。将噪声限制在高频率域上,使我们的相似度得到提高。通过结合所有这些方法,能够达到我们的最高结果。

综上所述,我们引入了黑盒攻击这个新的领域,结合现有的和新颖的方法,能够展示我们方法的可行性,并为未来的研究打开新的大门。

-

会物体识别和语音识别的nao机器人2015-02-13 0

-

请问电销机器人智能语音识别的原理是什么?2018-06-12 0

-

自动语音识别的原理是什么?2021-06-15 0

-

迁移学习2022-04-21 0

-

机器学习简介与经典机器学习算法人才培养2022-04-28 0

-

对抗样本真的是bug吗?对抗样本不是Bug, 它们是特征2019-05-10 4641

-

基于动量的迭代算法来构造对抗扰动以攻击黑盒和白盒模型2019-05-15 5652

-

语音识别的技术历程2019-08-22 4470

-

语音识别的两个方法_语音识别的应用有哪些2020-04-01 5999

-

人工智能:机器学习模型存在着对抗样本的安全威胁2020-08-27 3601

-

深度学习模型的对抗攻击及防御措施2021-03-12 1132

-

基于深度学习的自然语言处理对抗样本模型2021-04-20 811

-

GAN图像对抗样本生成方法研究综述2021-04-28 768

-

情感语音识别的研究方法与实践2023-11-16 848

-

ASR与传统语音识别的区别2024-11-18 459

全部0条评论

快来发表一下你的评论吧 !